Vergleich: ABAKUS Praxiserfahrung vs. Google-Ranking-Studie

Im Dezember 2016 erschien die alljährliche Google-Ranking-Studie zu den aktuellen Ranking-Faktoren der Search- und Content-Performance-Plattform Searchmetrics. Auf Basis eines Keyword-Sets von 10.000 informationsorientierten Suchbegriffen wurden die ersten 20 Suchergebnisse auf Google hinsichtlich bestimmter Faktoren ausgewertet. Zusätzlich wurden Rang-Korrelations-Koeffizienten berechnet. Auch wenn diese Studie im Allgemeinen „Ranking-Faktoren-Studie“ genannt wird, handelt es sich hier um Korrelationen. Wichtig zu wissen ist, dass hohe Korrelationen dabei nicht zwangsläufig wichtige Ranking-Faktoren bedeuten müssen. Wie bei vielen Studien und Analysen von rankingrelevanten Signalen, kann auch dieser Ansatz dem Webmaster helfen. So kann er beispielsweise herauszufinden, was bei Google gut positionierte Webseiten gemeinsam haben und was sie von schlechter rankenden Seiten unterscheidet.

Mit Interesse haben wir die Studien-Ergebnisse verfolgt und möchten die wichtigsten davon mit unserer jahrelangen Praxiserfahrung vergleichen. Sind die Korrelationen stimmig? Bewerten wir die gleichen Aspekte als rankingrelevant oder gibt es hier Abweichungen?

In unserem Praxisvergleich haben wir uns an folgenden Themenkomplexen orientiert und geben zu jeweils wichtigen Unterpunkten unsere Einschätzung:

Content-Faktoren – Onpage

In der diesjährighen Studie neu eingeführt wurde der Faktor „Content-Relevanz“. Hierbei wurden textliche Inhalte semantisch und vom Keyword losgelöst bewertet. Da auch unserer Erfahrung nach eine Relevanz-Wertung weg vom einzelnen Keyword hin zu einem ganzheitlichen Ansatz (holistische Inhalte) besteht, ist das Erfassen einer Korrelation in diesem Punkt sinnvoll. Allerdings kann ein Webmaster aufgrund der angegebenen hohen Korrelationswerte für Webseiten auf vorderen Positionen bei Google nicht erkennen, was die Content-Relevanz der Top-Positionen konkret ausmacht. Ein „Inspirieren lassen“ von solchen hochwertigen Inhalten ist also nicht so ohne weiteres möglich.

In die Content-Relevanz spielt die Länge von Texten, hier die reine Wortanzahl, hinein. Normalerweise birgt ein längerer Text auch mehr Informationen und kann unterschiedliche Suchintentionen besser abdecken. Deswegen bestätigt auch die Praxis, dass Seiten mit mehr Text oft besser ranken als Seiten ohne oder mit sehr wenig Text. Gleichzeitig erhöht sich bei längeren Inhalten die Anzahl der Keywords, die für eine Seite als relevant erachtet werden. Die Erhöhung erfolgt aber nicht überproportional. Das bedeutet, auch bei längeren Texten, die gut ranken, steigt die Keyworddichte nicht. Wir gehen hier erfahrungsgemäß von einer idealen Keyworddichte von 1-3% aus.

Und für alle Verfechter der 0%-Keyword-Strategie: alle in der Studie getesteten, gut positionierten Seiten verfügen über eine gewisse Anzahl an Keywords im Body. Interessant ist die Korrelation der Keywords im Title. Bei weniger als der Hälfte der gut rankenden Seiten auf Position 1 – 20, wird das rankende Keyword im Title verwendet. Unserer Erfahrung nach stimmt hier die hohe Korrelation nicht mit dem Ranking-Faktor überein. Nach wie vor ist der Title mit dem entsprechenden Keyword das wichtigste Onpage-Signal für Suchmaschinen. Gleiches gilt für den Suchbegriff in der wichtigsten Überschrift, der H1. Auch wenn nur knapp ein Drittel der Top-rankenden Seiten das Keyword in der H1-Überschrift verankert hatten, empfehlen wir die Verwendung in dem zweitwichtigsten Onpage-Element.

Eine mögliche Erklärung für diese Differenz kann allerdings sein, dass sehr gut aufgestellt Seiten, besonders Startseiten, oft für eine Vielzahl von Keywords ranken. Aus diesem Grund finden sich dann nicht alle Suchbegriffe im Title oder der H1 wieder. Auch verfügen, je nach Content-Management-System oder Template, oft gerade Startseiten nicht über die wichtige H1-Überschrift. Wurden für die Studie viele Startseiten ohne H1 oder mit multiplen Rankings, die sich nicht in der H1 widerspiegeln, herangezogen, wäre auch so eine Diskrepanz mit der Praxiserfahrung erklärbar.

Doch generell bestätigen auch wir den Trend weg vom einzelnen Suchbegriff und fassen zusammen: Die Relevanz des einzelnen Keywords nimmt immer weiter ab. Dies ist auch durch die neuen Machine-Learning-Algorithmen von Google bedingt. Gute Rankings basieren auf der holistischen Optimierung von Texten auf Themen-Ebene (Themen-Cluster). Daher spielt das Keyword an sich mittlerweile eine eher untergeordnete Rolle. Die Content-Relevanz für Google bemisst sich an der Wertigkeit und dem Informationsgehalt von Inhalten. Die Fokussierung auf einzelne Suchbegriffe ist nicht für den Content relevant.

User Signale = Nutzerverhalten

Zu den wichtigsten Metriken des Nutzerverhaltens gehören:

-

-

- Click-Through-Rate (die Klickrate auf Suchergebnisse, auch kurz: CTR)

- Time on Site (Verweildauer auf der Seite)

- Bounce Rate (Absprungrate)

-

Das Feedback der Nutzer ist eine direkte Interaktion, die Suchmaschinen auf Relevanz von Inhalten unmittelbar schließen lässt. Dahinter steht die Annahme: Besucher einer Webseite, deren Suchabsichten befriedigt werden, verweilen im Normalfall länger auf einer Seite und springen seltener in die Suchergebnisse zurück.

Die in der Studie angegebenen Klickraten von 29 – 44% auf den Positionen eins bis drei sind sehr vorsichtig zu bewerten. Grund ist die Fülle von Suchanfragen, für die Google bereits jetzt eigene Ergebnisse vor den eigentlichen organischen Treffern ausgibt. Häufig erscheint in Zusammenhang mit weiteren Werbeanzeigen das erste organische Suchergebnis gerade noch so im sichtbaren Bereich der Ergebnisseite. In solchen Fällen nehmen die Klickraten auf den ersten Positionen dramatisch ab. Hierbei ist es auch völlig irrelevant, ob Bücher, Rezepte, Hotels oder Antworten auf Fragen (direct answers) gegoogelt werden.

Die Bounce Rate (= Absprungrate) misst, wie viel Prozent der Nutzer nur eine einzige Seite nach dem Klick auf ein Suchergebnis aufgerufen haben und dann wieder zu den Suchergebnissen zurückkehren. Das allein lässt zwar noch keinen Rückschluss auf die Qualität eines Inhalts zu, denn ein Nutzer kann ja auch bei Erfüllung seiner Suchintention „bouncen“ (Beispiel: Wettervorhersage). Jedoch kann in Kombination mit anderen KPIs sowie Zweck und Art einer Seite (Info-Seite, Produktseite etc.), die Absprungrate ein wertvolles Kriterium für die Relevanz einer URL sein.

Handelt es sich nicht um eine informationsgetriebene Webseite, halten wir prinzipiell Absprungraten von 50% und mehr für kritisch. Die in der Studie im Vergleich zum Vorjahr leicht gestiegene Verweildauer je Seite lässt sich auch mit der ebenfalls gestiegenen Content-Länge begründen. Längere Texte benötigen längere Lesezeit, sofern sie informativ und gut aufbereitet sind.

Auch wenn Vertreter von Google es noch nicht so klar formuliert haben, sind auch wir der Überzeugung: das Nutzerverhalten ist ein sehr wichtiger Messwert für die Suchmaschine. Zusätzlich ist auch für die Relevanzbewertung insgesamt, dieser Faktor sehr wichtig, da es einen echten Rückschluss auf die Nutzerzufriedenheit und Abdeckung der Suchintention erlaubt.

Technische Faktoren – Onsite

In diesen Bereich fallen Faktoren, die die Struktur einer Webseite seitenübergreifend bestimmen. Die erkannte hohe Korrelation einer guten Webseite mit dem Vorhandensein einer H1-Überschrift (unabhängig von den verwendeten Keywords) können wir bestätigen. Gut rankende Seiten verfügen generell über eine logisch aufgebaute H-Tag-Struktur mit der Verwendung der wichtigen H1 und aller anderen Überschriftenebenen darunter.

Der Umstand der wachsenden Anzahl von HTTPS-Seiten unter Top gerankten Webseiten ist unserer Meinung nach zum einen auf ein offizielles Google-Statement zurückzuführen, in dem eine Verschlüsselung als echter Ranking-Faktor benannt wird. Zum anderen dürfte es daran liegen, dass Google für 2017 angekündigt hat, dass nicht auf HTTPS umgestellte Seiten im Google Chrome Browser als „unsicher“ markiert werden. Da viele Shops, zumindest im Warenkorb und dem Bestellprozess, bereits ein SSL-Zertifikat nutzen, empfehlen wir die komplette Webseite auf HTTPS umzuziehen.

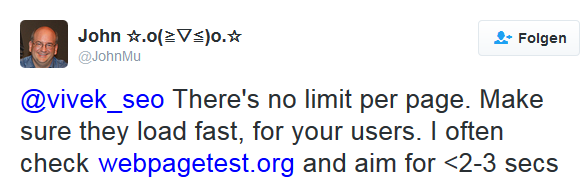

Der korrelierende Faktor zu den Seitenladezeiten hat für große Verwunderung bei uns gesorgt. Seiten, die in den Top-20 der Desktop-Suche ranken, benötigen eine durchschnittliche Ladezeit von 9,5 Sekunden. Diese Ladegeschwindigkeit überschreitet bei Weitem den optimalen Bereich von 2 – 3 Sekunden und wird in der Praxis von Google mit Ranking-Nachteilen geahndet. Sehr schnelle Seiten hingegen werden normalerweise nicht „belohnt“, da die Suchmaschine dies für eine gute Performance schlichtweg voraussetzt.

Zitat von John Mueller – Webmaster Trends Analyst bei Google:

Quelle: https://twitter.com/JohnMu/status/802420206375079936

Der Anstieg von mobile-freundlichen Webseiten ist in den letzten Jahren unserer Meinung nach weniger durch diverse Bemühungen seitens von Google initiiert worden. Vielmehr dürfte das neue mobile Verhalten der Nutzer und Zielgruppe einer Webseite ausschlaggebend sein. Webmaster haben erkannt: zunehmend mehr User kommen über mobile Endgeräte auf die eigene Webseite und wollen dort Aktionen und Conversions tätigen. Wer allerdings noch nicht über eine mobile Version seines Webangebotes verfügt, sollte dies nun auch aus SEO-Gründen in Betracht ziehen. Google kündigte nämlich an, auf eine mobile-first-Indexierung umzustellen. Der bisherige Desktop-Index wird dann nicht verschwinden, er wird aber nicht so aktuell sein wie der mobile Index. Wir gehen von dieser Umstellung noch in 2017 aus.

Social Media Signale

Social Media oder social Signals wurden in der Ranking-Faktoren-Studie von folgenden sozialen Netzwerken betrachtet:

-

-

- Google+

-

Die Studie zeigt eine sehr hohe Korrelation zwischen Social Media Signalen und Ranking-Positionen. Die Korrelation ist so hoch, wie bei keinem anderen Ranking-Faktor. Besonders Facebook hält hier seine Spitzenreiter-Position unter den Social Media Plattformen weiter aufrecht.

Allerdings können wir in der Praxis beobachten, dass oft besonders große Webseiten/Brands sehr aktiv im Bereich Social Media sowie anderen Marketing-Kanälen sind. Daher könnte sich allein durch die umfangreicheren Aktivitäten eine höhere Relevanz, Sichtbarkeit und bessere Positionierungen ergeben. Diese können dann nicht eindimensional an ein Mitwirken in sozialen Netzwerken zurückgeführt werden. Dennoch ist das Thema Social Media spannend und birgt viel Potential für den Marketing-Kanal.

Backlinks – Offpage

Bei den Offpage-Faktoren stellen Backlinks weiterhin eines der wichtigsten SEO-Signale dar. Allerdings ist Backlink nicht gleich Backlink. Hier spielt immer stärker die Qualität jedes einzelnen Links eine wichtige Rolle. Wenige gute Backlinks können mehr bewirken, als hunderte Links aus minderwertigen Quellen.

Die in der Studie beschriebene – durch selbstlernende Algorhitmen und komplexe Erfassung der Sucherintention – gesunkene Relevanz für Backlinks, konnten wir in der Praxis noch nicht feststellen. Google schaut zwar wohl sehr genau auf diese Signale und kann die Qualität von Backlinks immer besser bewerten (und auch abwerten) – Allerdings ist das Potential, welches sich hinter guten Empfehlungen in Form von Backlinks verbirgt, bis heute durch keinen anderen einzelnen Faktor ersetzbar.

Mein Fazit zu den Ranking-Faktoren

Die Google-Ranking-Studie führt eine Vielzahl an Korrelationen für die unterschiedlichen Einflussfaktoren auf eine Webseite auf. Diese decken sich auch in vielen Fällen mit unserer Praxis-Erfahrung. Das monokausale Herunterbrechen von Top-Positionen auf einzelne Faktoren ist so dennoch nicht möglich. Besonders in Zeiten von maschinellem Lernen, Google-Updates in Echtzeit und immer stärkerer Differenzierung von Nutzer-Intentionen verlieren einzelne Faktoren an Kontur. Vielmehr verbinden sich einzelne Faktorern immer mehr mit einer Vielzahl anderer Metriken zu einem ganzheitlichen Relevanz-Faktor. So ist es nicht verwunderlich – und unserer Meinung nach folgerichtig -, dass dies die letzte Studie ihrer Art von Searchmetrics zu gängigen Ranking-Faktoren ist.

Wer seine Webseite für Nutzer und Suchmaschinen gut aufstellen möchte, sollte sich weniger auf einzelne Elemente konzentrieren, als vielmehr auf das globale Nutzererlebnis.

-

-

- Werden alle Intentionen, mit denen ein Interessent vorbeischaut, abgedeckt (Information, Beratung, Kauf-Option)?

- Bietet die Webseite einzigartige, informative Inhalte in großer Tiefe?

- Bietet die Webseite einen Mehrwert, den andere Marktteilnehmer nicht besitzen?

- Lässt sich die Webseite gut bedienen und führt sie den Besucher auf unterschiedlichen Wegen in die Tiefe des Angebots?

-

Wer diese Fragen für seine Webseite mit „Ja“ beantworten kann, beachtet bereits den holistischen Ansatz und braucht sich um einzelne Faktoren keine Sorgen zu machen.

Weiterführende Quellen

http://www.searchmetrics.com/de/knowledge-base/ranking-faktoren

https://de.wikipedia.org/wiki/Rangkorrelationskoeffizient

https://webmasters.googleblog.com/2014/08/https-as-ranking-signal.html

https://security.googleblog.com/2016/09/moving-towards-more-secure-web.html

https://webmaster-de.googleblog.com/2016/11/mobile-first-indexierung.html