Inhalt

- Das Internet

- Webkataloge

- Das Crawling

- Domains

- Kommerzielle Suchmaschinen

- Suchmaschinenoptimierung

- Spamming

- Technische Suchmaschinenoptimierung

- Grundlagen von SEO

- Inhaltliche Optimierung

- Inhaltsarten

- Interne Verlinkung

- Externe Verlinkung

- Deeplinks

- Website Performance bzw. Page Experience

- Suchmaschinenmarketing

- Nutzerverhalten

- Suchmaschinenrankings

- Web Analytics

- SEO-Monitoring

- Suchmaschinenoptimierung Kosten

- SEO Tools

- On-SERP SEO

- Onpage Optimierung

- Offpage Optimierung

- Onsite Optimierung

- SEO Lexikon

- Lokale Optimierung

- Keyword-Recherche

- Duplicate Content

- SEO Beratung

- SEO Workshop

- SEO als Vertriebskanal

- Zusammenfassung

- (Fazit) Was ist SEO?

Das Internet

Die Anfänge des Internets liegen lange zurück. Der Vorläufer des Internets entstand durch den Zusammenschluss autonomer Rechnernetzwerke in den späten 1960er Jahren. Ab 1981 ging es mit TCP/IP los und 1989 kam das World Wide Web. Suchmaschinen und so auch Suchmaschinenoptimierung gibt es, weil auf Grund der vielen mit einander vernetzten Computer im Internet Suchmaschinen benötigt wurden, um die Inhalte allen Nutzern zugänglich zu machen. Die Suchmaschinen haben Schwächen. Der SEO hilft den Suchmaschinen die relevantesten Inhalte für eine Suchanfrage zu finden. Oder?

Webkataloge

Zuerst kam der Webkatalog, dann die Suchmaschine. Der erste Webkatalog war Tim Berners-Lee‘s 1991 veröffentliche „Virtual Library“ – noch zu sehen unter http://vlib.org/. Danach gab es wohl nie wieder einen vollständigen Webkatalog, der tatsächlich alle Seiten des World Wide Web beinhaltete. Auf Grund der Vielzahl der Webseiten mussten die Inhalte der fremden Netzwerke durchsuchbar sein und so wurden die ersten Suchmaschinen entwickelt. Diese Softwares durchsuchen Abschnitte der autonomen Netze und indexierten die Inhalte.

Das Crawling

I.d.R. kommen diese Softwares (Crawler oder Bots genannt) über Verweise (Hyperlinks) auf die jeweiligen Internet-Adressen (URLs – Uniform Resource Locator).

Um diesen Vorgang zu beschleunigen kann man i.d.R. den Suchmaschinen URLs auch melden, bzw. die URLs eintragen. (Auch bei Google ist das heute noch möglich, allerdings nur als Webseitenbetreiber über die Google Search Console.)

Man kann die Suchmaschinensoftware in zwei grobe Bereiche teilen: Den Teil der Software, der Webseiten auffindet (Webcrawler oder Bot) und den Teil der Software, der die gefundenen Inhalte bewertet und in eine bestimmte Reihenfolge bringt. Das Crawling ist also nur eine Aufgabe der Suchmaschine.

Die Steuerung der Indexierung erfolgt u.a. mit der robots.txt und dem Robots-Metatag.

Domains

Eine Domain ist i.d.R. eine sprechende Internet-Adresse, die auf einen bestimmten Internet-Computer (Server), bzw. dessen IP Adresse geroutet wird. Auf dem Computer werden die Webseiten der Domain gespeichert und so für Nutzer zugänglich gemacht. Die Domain gehört immer einer bestimmten Person. Je nach Top Level Domain (TLD, z.B. *.de oder *.com) gelten verschiedene Zuordnungen zu Ländern oder Zwecken. Für SEO sind die Domainnamen nicht relevant, aber zur Markenbildung unglaublich wichtig.

Kommerzielle Suchmaschinen

Seit dem Beginn der Kommerzialisierung des Internets Ende der 1980er Jahre sind Suchmaschinen auch wirtschaftlich wichtiger geworden. Eine kommerzielle Webseite braucht Nutzer und Kunden und somit SEO. Bei Hobby-Webseiten ist das weniger wichtig, doch auch als Hobby-Webseitenbetreiber freut man sich natürlich, wenn Internetnutzer die selbst geschaffenen Inhalte konsumieren. Bei kommerziellen Seiten spielen ganz klar wirtschaftliche Interessen eine große Rolle und über die Suchergebnisse erhält die Seite relevanten Traffic.

Immer mehr Abläufe sind digital, auch bei KMUs. Für diese ist es wichtig, dass sie auf der Webseite die Suchanfrage potenzieller Kunden beantworten können. Ohne Sichtbarkeit im Internet ist ein Unternehmen heutzutage quasi nicht vorhanden. So werden immer mehr Unternehmen von den Suchmaschinen abhängig. Mit über 90% dominiert Google den deutschen und auch andere europäische Märkte.

Unternehmen sollten vorsorglich SEO für verschiedene Suchmaschinen betreiben und darauf achten, dass die Firmenwebseite auch in anderen Portalen gut positioniert ist. Alternative Suchmaschinen, wie Startpage, Duckduckgo oder Ecosia nutzen zum Teil die Daten von Google oder Bing, reichern aber die Rankingergebnisse teilweise noch an, Duckduckgo kombiniert selbst gecrawlte Daten mit externen Daten und ist so eine Suchmaschine und Meta-Suchmaschine. Swisscows crawlt nach eigenen Angaben selbst ohne die Nutzung externer Dienste.

Suchmaschinenoptimierung

Schon zu Zeiten von Altavista, in den 1990er Jahren, begannen Webentwickler und Online-Marketing-Fachleute Methoden zu ersinnen, wie sie Webseiten in den Suchmaschinen besser gelistet bekommen und eine Steigerung der Besucherzahlen erreichen. Eines der ersten Bücher zum Thema SEO war „Marketing through search optimization“ von Alex Michael aus dem Jahr 2003. Der Begriff „Suchoptimierung“ („search optimization“) wird von Google konsequent mit „Suchmaschinenoptimierung“ ersetzt.

Eine Möglichkeit war schon früh die Nutzung der Meta-Elemente im Head-Bereich (<head>…</head>) des Quelltextes der Webseite. Der Titel (<title>-Tag), die Meta-Description (<meta name=“description“ content=“…“/>), die heute nicht mehr genutzten Meta-Keywords u.a. Informationen, die den Suchmaschinenrobotern helfen sollen den Inhalt der Seite zu erfassen und zu kategorisieren, wurden gefüllt und von den Suchmaschinen für die Auflistung ausgewertet.

Je nach Art der Webseite können verschiedene Meta-Elemente genutzt werden, z.B. Beschreibung, Schlüsselbegriffe, Autor, Anweisungen für Webcrawler, Cache-Steuerung, Ablaufdatum, geografische Informationen und Sprachinformationen usw.

Wobei die Nutzung der Schlüsselbegriffe bzw. Meta-Keywords heutzutage negative Auswirkungen haben könnte. Bei Yahoo/Bing und Google ist es so, dass die verwendeten Schlüsselbegriffe im Text der Seite vorkommen müssen UND es dürfen nicht zu viele sein. Werden diese Voraussetzungen nicht erfüllt, kann diese Art des SEO von der jeweiligen Suchmaschine als Spamversuch gewertet werden.

Das Metadatenschema Dublin Core hat sich nicht durchgesetzt, wird aber vereinzelt noch von Seitenbetreibern genutzt.

Die Suchmaschinen haben sich bis heute stark entwickelt. Mit Google haben wir eine global verbreitete und mächtige Suchmaschine, die teilweise sogar das gesellschaftliche Leben deutlich mitbestimmt.

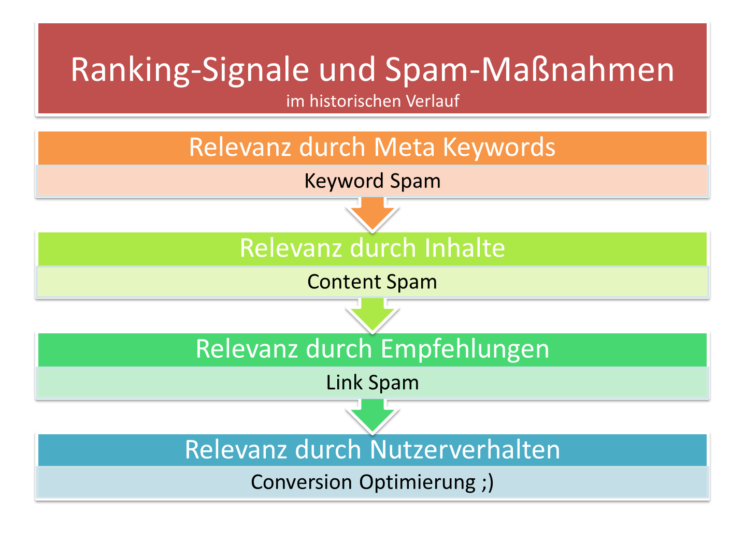

Früher haben die Suchmaschinen die Meta-Elemente ausgewertet, später kam die Auswertung der für den Nutzer sichtbaren Inhalte dazu. Dann wurden Verweise von fremden Domains mit in das Ranking gezogen. Heute sind wir im SEO so weit, dass auch das Nutzerverhalten in das Ranking bei z.B. Google mit einfließt.

Spamming

Was sich immer wieder zeigt ist, dass Seitenbetreiber versuchen einen Rankingvorteil für ihre Webseite zu erlangen. Bei den Meta-Keywords konnte man den Missbrauch am klarsten erkennen. Da dieser Tag nur für die Suchmaschinen war oder ist und kein normaler Nutzer, die dort veröffentlichten Inhalte zu sehen bekommt, wurden gerne viel mehr Keywords hinterlegt, als nötig oder sinnvoll gewesen wäre – für den tatsächlichen Inhalt.

In den Anfängen der Suchmaschinenoptimierung ging es auch noch darum möglichst viel Traffic auf die eigene Seite zu bekommen. Was der Nutzer dort machte, war erst einmal egal. Und die damaligen Suchmaschinen (in den 1990er Jahren) waren deutlich anfällig für Keyword-Stuffing bzw. Keyword-Spam.

Das heißt, dass wir den Fortschritt in der Suchmaschinen-Entwicklung eigentlich den Spammern zu verdanken haben. Die Suchmaschinenbetreiber haben immer wieder nach Wegen gesucht solche Manipulation von außen zu verhindern und mußten deshalb neue Bewertung-Kriterien ersinnen.

Neben Content-Spam und Linkspam gibt es weitere Spamarten, die hier aber nur genannt werden sollen, ohne näher darauf einzugehen, denn Spamming ist keine Suchmaschinenoptimierung im eigentlichen Sinne. Es gibt z.B.:

- Content Spam

- Domain Spam

- Link Spam

- Redirect Spam

- Cloaking

Die angewandten Ranking-Signale änderten sich über die Jahre und auch die Manipulationsmaßnahmen entwickelten sich.

Bild 1: Ranking-Signale und Spam-Maßnahmen im historischen Verlauf

Spamming ist sog. Black Hat SEO, im Gegensatz zu White Hat SEO. Die Grenzen sind aber oft fließend. Ein ambitionierter Webseitenbetreiber, der gerade mit der Webseite anfängt und Kommentare in Blogs schreibt ist nicht gleich ein Spammer, er will nur etwas Aufmerksamkeit für seine neue Domain. Da Kommentarlinks in Blogs i.d.R. „nofollow“ sind, also nicht von den Suchmaschinen verfolgt werden, unterstützen diese Links nicht im Google-Ranking, können aber den einen oder anderen Klick bringen – je nachdem, wie der Kommentar verfasst wurde.

Technische Suchmaschinenoptimierung

Die Ursprünge der Suchmaschinenoptimierung (SEO= Search Engine Optimization) liegen eher im technischen Bereich denn im Content-Bereich.

Die ersten CMS bzw. Shopsysteme hatten die Aufgabe viele Inhalte leicht handhabbar zu machen. Es ging z.B. darum einen Onlineshop so aufzusetzen, dass neue Produkte von der Software selbst bei der internen Verlinkung berücksichtigt wurden, dass bestimmte Merkmale für alle Produkte einer Kategorie gleich waren usw.

Die Aufgabe war für die damalige Zeit eine Herausforderung, denn es gab ja bisher nichts Vergleichbares. Darum lag der Fokus der Entwickler auf der Verwaltung der Produkte, den Bezahlmöglichkeiten usw. Die Suchmaschinen wurden anfangs nicht oder kaum berücksichtigt. Unter Umständen hat der Seitenbetreiber seinen Onlineshop in Webkataloge eingetragen.

Kryptische URLs mit zig Parametern wurden von den Webentwicklern in Kauf genommen. Dass sich ein Suchmaschinenroboter, der Crawler, darin verlaufen konnte war den Entwicklern nicht bekannt.

In der Konsequenz gab es Onlineshops, die nicht ihr volles Warensortiment in den Index der Suchmaschine bekamen und so viel ungenutztes Potenzial hatten. Jede Unterseite, jedes Produkt, jede Kategorie-Seite stellt per se eine Einstiegseite für den Nutzer einer Suchmaschine dar und lässt sich auf bestimmte Suchphrasen optimieren.

Die Aufgabe des SEO war es nun also dem Bot der Suchmaschine alle wichtigen URLs der Domain zugänglich zu machen. Und da die Konkurrenz bekanntlich nicht schläft, wurden Titles, Meta Descriptions und (bis zu einem bestimmten Zeitpunkt) die Meta Keywords gepflegt. Auch die Alt-Texte der Bilder wurden damals schon optimiert, wenn der SEO sich Gedanken über die Nutzung der verschiedenen HTML-Elemente gemacht hat.

Die Content-Optimierung war schon immer der wichtigste Punkt in der Suchmaschinenoptimierung, sobald die Bots alle wichtigen URLs indexieren konnten. Content is King galt schon im Jahr 2000.

Mit Google änderte sich etwas. Bei Google war nicht nur wichtig, welche Inhalte auf der Webseite vorhanden waren, sondern auch, ob von anderen Webseiten eine Bestätigung der Relevanz durch einen Link existierte. Die Erkenntnis, dass Rankings mit Links leicht manipuliert werden konnten, brachte die SEOs mindestens in ein Zwielicht und beeinflusste teilweise die Vorgehensweise der Black Hat SEOs.

Dass Suchmaschinen manipulierbar sind. ließ sicher den einen oder anderen nicht in Ruhe und so wurden bei den Black Hat SEOs Cloaking usw. populär. Bei seriösen SEO Agenturen sind das natürlich Praktiken, die grundsätzlich nicht denkbar sind. Die Webseite des Kunden wäre gefährdet und der Ruf beider – des Kunden und der Agentur – leicht ruiniert, wenn die Domain abgestraft würde.

Grundlagen von SEO

Bei der Optimierung der Website-Inhalte waren und sind bestimmte HTML Elemente wichtige Hebel, um eine gewissen Relevanz herauszustellen. Es handelt sich um die Grundlagen, man kommt aber kaum drum herum, sie auch anzuwenden.

Die Optimierung von Titles, Meta Descriptions und Überschriften stellen die Basics der von SEO dar, sind deshalb aber nicht banal. Wie der Einband eines Buches sollten die Meta Daten gesehen werden. Der Title ist der Buchrücken, den man im Bücherregal als einzigen Teil des Buches sieht und die Meta Description ist der Buchdeckel. Die Überschriften, vor allem der H1 Tag, sind Teil des Inhaltsverzeichnisses.

Nicht zuletzt für den Bereich On-SERP SEO ist der Title sehr wichtig, wenn es darum geht den Nutzer anzusprechen. Wenn der Title „clicky“ formuliert ist hat das deutliche Vorteile.

Inhaltliche Optimierung

Die Optimierung des Content-Bereichs einer Webseite begann mit der Keyword-Dichte und Keyword-Verteilung im Text. Die prozentuale Häufigkeit der Suchbegriffe im Fließtext der Seite spielte anfangs eine gewichtige Rolle. Einige „Spezialisten“ vertraten die Meinung, dass es wichtig sei vor allem am Anfang des Textes möglichst häufig das jeweilige Keyword zu nutzen. Professionelle SEOs, die genug Erfahrung hatten gingen davon aus, dass es besser wäre den wichtigen Suchbegriff über die ganze Seite zu verteilen und nicht nur im Content-Bereich der Seite zu verwenden. Das waren die Anfänge der Content-Optimierung.

Heute wird mit WDF*IDF gearbeitet und verschiedene Grade der latent semantischen Optimierung (LSO) praktiziert. Es geht grundsätzlich darum, dass in einem relevanten Text zu Begriff A auch andere Begriffe auftauchen müssen, z.B. in einem Text zum Thema „Bahnfahrt“ wird auch über die Fahrkarte, den Speisewagen und eine Verspätung geschrieben.

Der Aufbau und die Formatierung des Inhalts spielt eine große Rolle. Lässt sich der Inhalt durch Überschriften, Aufzählungen, Schriftgröße und Schriftfarbe bzw. Kontrast zum Hintergrund usw. gut konsumieren?

Aber nicht nur der Fließtext ist wichtig, weitere Inhaltsarten spielen für die Relevanz und für die Suchintention, bzw. deren Stillung eine große Rolle.

Beispiele für Inhaltsarten oder Daten, die der Nutzer zu finden hofft, findet man bei erfolgreichen Wettbewerbern. In wenigen Fällen ist es nur Text, aber nicht zu jedem Thema kann man z.B. ein Video produzieren.

Inhaltsarten

Je nach User Intent, also Suchintention des Nutzers, unterscheiden sich die Inhalte, die zur jeweiligen Suchphrase passen. Jemand, der sich über ein Urlaubsziel informieren will, erwartet sicher Text mit Informationen und Tipps und Bildern, ggf. Videos. Sucht derselbe Nutzer nach einer Reiserücktrittsversicherung, braucht er ein durchdachtes Formular, um seine Angaben machen zu können und die Daten (sicher) abzuschicken.

Zusätzlich werden heutzutage die Inhalte auf die anzunehmende Customer Journey Stage angepasst, in der sich der User gerade befindet.

Interne Verlinkung

Die Verlinkung der Seiten einer Domain unter einander ist ein mächtiges Werkzeug. Sowohl der genutzte Linktext, als auch die Anzahl der Links (bzw. Anzahl der intern verlinkenden Dokumente) zu einer Unterseite und auch die Position des Links auf der linkgebenden Seite machen einen Unterschied, wie stark die jeweilige Seite bewertet wird.

Bei einer site: Abfrage bei Google werden die Seiten nach Stärke sortiert aufgelistet. I.d.R. ist die Startseite der erste Eintrag, dicht gefolgt vom Impressum oder anderen Unterseiten, die von allen anderen Unterseiten verlinkt sind. Hier zeigt sich die Macht der internen Links. Die Suchmaschine folgt dem Prinzip, dass eine häufig verlinkte Seite wichtig sein muss.

Durch den Einsatz von Content Management Systemen lassen sich einige Vorteile durch den Einsatz von Widgets oder Ad-ons bei der internen Verlinkung erzielen. Allerdings leidet so auch oft die Ladezeit bzw. die Page Experience beim Nutzer.

Externe Verlinkung

Vor allem bei Google spielt die Anzahl und die Qualität von Links zur eigenen Domain eine sehr große Rolle. Versuche seitens Google durch soziale Signale (Google Buzz, Google Plus u.a.) von den leicht zu manipulierenden Offpage-Signalen wegzukommen, scheiterten regelmäßig.

Mehr als 50% im Google-Ranking werden durch externe Signale bestimmt. Die wichtigen Fragen sind:

- Wer verlinkt auf mich?

- Art der Webseite

- Standing dieser (Sub)Domain bei Google

- Thema der Webseite

- Umfeld der Webseite

- Alter der Webseite

- Dauer der Verlinkung/ Alter des Links

- An welcher Stelle ist der Link auf der Webseite zu finden?

- Startseitenlink / Link von einer Unterseite

- Position des Links: Content-Bereich, Sidebar, Footer

- Single- oder Sitewide-Link

- Art des Links?

- Grafik-, Text-Link (Grafik mit Alt-Text) oder Javascript-Link

- Follow oder nofollow

- Inhalt des Links

- Linktext

- Generischer Begriff, Compound Anchor Text oder nicht-relevanter Linktext bzw. Alternativtext bei einer Grafik

- Linktext

Nur, wenn eine Webseite für ihre eigenen Inhalte gut rankt, kann sie auch Relevanz oder Trust vererben, d.h. an die verlinkte Webseite weitergeben. Natürlich muss der Linkjuice auch fließen können, der Link muss für Suchmaschinen verfolgbar sein, denn sonst stellt er keinen Support im Ranking dar.

Auch wichtig sind Links aus der zweiten Ebene. Hat die Domain, die auf meine Seite verlinkt selbst für mein Thema relevante einkommende Links von starken Domains? Wenn die eigene Domain sozusagen über Eck von einer Autorität zum Thema verlinkt wird, stärkt das die Relevanz der Seite.

Mit dem Link Check im SEO DIVER kann man kostenlos die eigene und auch fremde Domains analysieren. Das Tool Backlink Trust Points zeigt die Links in der zweiten und dritten Ebene. Mit dem Link Graph von z.B. Majestic SEO kann man solche Zusammenhänge auch sehr gut grafisch darstellen.

Der Linkaufbau – egal, ob man ihn selber macht oder von einer SEO Agentur durchführen lässt – benötigt einiges an Ressourcen und bietet leider auch einige Fallstricke. Unter Umständen werden vom Laien Links aufgebaut, die der Domain schaden und, im schlimmsten Fall, nicht mehr abgebaut werden können. Es empfiehlt sich zumindest eine Beratung oder einen Workshop zum Thema Linkbuilding in Anspruch zu nehmen.

Deeplinks

Deeplinks führen in die Tiefe der Webseite. Das Gegenteil ist ein Startseitenlink, also ein Link zur Startseite. Die Startseite ist aus CRO (Conversion Rate Optimierung)-Sicht i.d.R. eine schlechte Landingpage, da der Nutzer mind. einen Klick mehr machen muss, um an das Conversion-Ziel zu kommen. Es ist selbstverständlich kein Fehler, wenn der Nutzer auf der Homepage einsteigt, aber jeder Klick kostet ca. 30% des Traffics. Steigt der Nutzer auf einer Unterseite ein, ist er z.B. in einem Onlineshop bereits einen Klick näher an der Kasse. Das erklärt, warum üblicherweise Kategorieseiten o.a. Gabelseiten für SEO-Maßnahmen bevorzugt werden.

Website Performance bzw. Page Experience

Die Ladezeit einer Webseite ist ein kritischer Punkt. Der Übergang von der Suchmaschine zur eigenen Webseite muss möglichst harmonisch erfolgen, der Nutzer ist grade ungeduldig, weil kurz vor der Stillung seines Bedürfnisses ist. Wenn da die Seite zu langsam lädt, wird der User schnell das am häufigsten genutzte Navigationselement im Internet, den Browser Back Button, klicken.

Weiter geht es dann auf der Webseite selbst, wenn teilweise recht nervige Ads das Layout verschieben, Inhalte nicht gleich funktionieren und die Nutzung der Seite zumindest nicht zügig erfolgen kann.

Vor allem im mobilen Bereich, auf kleinen Endgeräten, ist das lästig und so ist auch verständlich, dass Google diese Werte in die Bewertung integriert hat.

Von Google gibt es verschiedene Tools, u.a. Lighthouse im Chrome Browser oder das Page Experience Tool, um die Website-Performance, und so ein Stück weit die Page bzw. User Experience messen bzw. beurteilen zu können.

Bing bietet das „Tool zum Testen der Benutzerfreundlichkeit von Webseiten auf mobilen Geräten“. In den Yandex Webmaster Tools finden wir u.a. „Audit pages for mobile compatibility“. Yandex spielt in Deutschland, bzw. für deutschsprachige Nutzer kaum eine Rolle, aber da sich Dinge auch ändern können, sollte man hin und wieder einen Blick über den Tellerrand tätigen.

Suchmaschinenmarketing

Im Vergleich zu anderen Online Marketing-Kanälen, wie Social Media, E-Mail Marketing und Google Ads / Pay per Click und anderer Suchmaschinenwerbung bzw. Search Engine Advertising, ist SEO der nachhaltigste Kanal. SEO ist keine Werbung im klassischen Sinne, es wird kein Bedarf geweckt. Vielmehr ermöglicht die Suchmaschinenoptimierung durch eine breit aufgestellte Content-Strategie langfristiges Wachstum, verbessert die Nutzererfahrung und stärkt so die Markenbindung.

Nutzerverhalten

Das Verhalten der Internet-Nutzer wird seit dem Google RankBrain Update 2016 offiziell mit in die Bewertung von Webseiten durch Google berücksichtigt. Die Klickrate in den Ergebnissen, die Absprungrate auf der Webseite, Time on Site, Pageviews uvm. lässt Google erkennen, wie der Nutzer die Webseite annimmt, ob es für seine Suchphrase bzw. Suchintention ein gutes Ergebnis darstellt. Wenn sich der Nutzer mit der Seite auseinandersetzt, mit ihr interagiert, gefällt ihm die Seite u.U. Bei einem offensichtlich schlechten Ergebnis würde der Nutzer den Browser Back Button drücken oder die Seite schließen. Abonniert er z.B. einen Newsletter, lädt sich eine Datei herunter oder legt ein Produkt in den virtuellen Warenkorb, ist die Seite höchstwahrscheinlich sogar vertrauenswürdig.

Der wichtigste Wert aus SEO-Sicht ist aber die Absprungrate. Wenn der Nutzer nicht bounct, ist die erste Hürde genommen. Der Seitenbetreiber hat durch das Nutzerverhalten eine externe Bestätigung, dass diese Unterseite zum Suchbegriff, bzw. zur Suchintention passt. Aus diesem Grund ist die Conversion Rate Optimierung auch für die Suchmaschinenoptimierung wichtig. Das funktioniert recht einfach mit einem Call to Action im sichtbaren Bereich der Webseite, um den Nutzer auf der Seite zu halten und nicht zurück zu den Suchergebnissen bouncen zu lassen.

Suchmaschinenrankings

Die Rankings bzw. die Positionierungen von Webseiten in den Suchmaschinen-Ergebnissen kommen durch verschiedene Kriterien zustande. Die Meta-Keywords werden nicht mehr gewertet, weil sie zu leicht zu manipulieren sind. Andere Meta-Elemente, die im <Head>-Bereich der Webseite zu finden sind, spielen hingegen direkt oder indirekt eine Rolle.

Der Title ist ein sehr wichtiges HTML Element und zu betrachten, wie der Rücken eines Buches im Regal. Er muss aussagekräftig und kurz formuliert werden. Die Meta-Description hingegen hat keinen direkten Einfluss auf die Positionierung einer Webseite, kann aber den Nutzer zu Klick ziehen, wenn sie gut formuliert ist.

Überschriften sind ebenfalls wichtig und sollten hierarchisch logisch eingesetzt werden. Nach einer H1 Überschrift folgt logischerweise eine H2 Überschrift usw.

Bildnamen, Alternativ-Texte von Bildern, die zum Inhalt der Seite gehören, Linktexte usw. spielen ebenfalls eine Rolle bei der Ermittlung der Relevanz einer Webseite für ein bestimmtes Thema. Bei Google gibt es nach Googles Aussage mehr als 200 Rankingfaktoren.

Grundsätzlich lassen sich vier Bereiche nennen: Technik (interne Verlinkungslogik, Ladezeit bzw. Page Experience u.a.), Redaktion (Texte inkl. Title, Überschriften, Inhaltsarten usw.) und der Offpage-Bereich. Bei diesem geht es u.a. darum, ob andere Webseiten auf die eigene Webseite verlinken und wie sie das tun. Der verwendete Linktext kann die Relevanz einer angelinkten Webseite steigern. Aber nicht nur der Linktext, sondern auch der den Link umgebende Text fließt in die Bewertung ein.

Die Krönung der Suchmaschinenoptimierung sind die Nutzerwerte. Hier muss sich der i.d.R. technisch starke SEO mit der Psyche der Nutzer beschäftigen. Wenn ich dem Nutzer eine gute Erfahrung (good user experience) ermögliche, habe ich ihn für mich bzw. meine Website gewonnen. Im besten Fall wird er von Nutzer zum Kunden.

Bei Yandex aus Russland zum Beispiel werden Links von extern nicht in das Ranking einbezogen.

Web Analytics

Für die Klickraten zur eigenen Webseite bieten sich die Webmaster Tools der verschiedenen Suchmaschinen an. Jeder SEO sollte mind. zwei Webmaster Tools aktiv nutzen, um einen breiten Blick auf das Nutzerverhalten zu bekommen. Google, Bing/Yahoo sowie Yandex bieten hier Daten. Yandex ist allerdings für den deutschsprachigen Markt kaum relevant, liefert aber z.B. technische Informationen zur Webseite. Auch Seznam bietet Webmaster Tools, die sind allerdings schon seit einigen Jahren im Beta Stadium.

Um die Nutzer besser zu verstehen, brauche ich Zahlen. Wie hoch ist die Absprungrate auf meinen wichtigsten Seiten? Beschäftigt sich der Nutzer mit den Inhalten meiner Seite oder verliere ich ihn schnell? Wenn der User bounct und zurück zu Google geht, registriert Google das. Steigen viele Nutzer schnell wieder aus, wird Google meine Seite für diesen Suchbegriff nicht mehr top ranken lassen, denn Google muss gute Ergebnisse liefern.

Google Analytics ist mittlerweile ein Durcheinander an Zahlen, die mehr und mehr Einsteiger abschrecken, weil sie keine Erkenntnis daraus ziehen können. Eine Alternative, die auch DSGVO-konform läuft, ist Matomo (früher Piwik). Diese kann auf dem eigenen Server betrieben und so eingerichtet werden, dass sie den EU-Vorschriften genügt – auch als Cloud-Lösung.

Es ist sehr wichtig, dass man zum einen seine wichtigen Suchbegriffe (weniger ist mehr) regelmäßig auf die aktuelle Position prüft und zum anderen die Entwicklung der Benutzerzahlen auf dem Schirm hat.

Auch die Traffic-Quellen seiner Webseite muss man kennen. Da gibt es neben den Suchmaschinen z.B. der Traffic über Referrer, der immer wichtiger wird. Dieser ist wertvoll, weil der Nutzer in seiner Customer Journey bereits fortgeschritten und so näher an der Conversion ist. Der Traffic über Suchmaschinen liefert grob geschätzt 80% informational Traffic.

SEO-Monitoring

Das Monitoring im SEO lässt sich in verschiedene Bereiche teilen. Das Keyword-Monitoring stellt quasi das Ergebnis der SEO-Bemühungen dar. Keyword-Rankings sind u.a. auch die Basis für die Sichtbarkeit in Sistrix. Es sollte ein kleines Set von Suchbegriffen sein, 20 – 50 Suchbegriffe, deren Positionen wöchentlich oder monatlich ausgewertet werden.

Das Backlink-Monitoring ist etwas weniger engmaschig, als das Keyword-Monitoring. Es ist aber wichtig mind. einmal im Jahr, besser alle 6 Monate das Backlink-Profil zu überprüfen. Im besten Fall richtet man sich einen Alert für neue und weggefallene Links ein. Aber auch die manuelle Überprüfung reicht.

Suchmaschinenoptimierung Kosten

Eine gute SEO-Agentur versucht kostengünstig zu arbeiten. Vor allem im B2B-Bereich ist es üblich, dass die Unternehmen sich das Wissen ins Haus holen und durch Inhouse Workshops in ihre Mitarbeiter investieren. Wenn man als Seitenbetreiber die Kosten für SEO gering halten will, braucht man Mitarbeiter, die die SEO-Arbeit übernehmen, denn einer muss die Aufgaben erledigen.

Wichtig ist, dass der Seitenbetreiber die großen Stellschrauben kennt, die eine deutliche Verbesserung in den Rankings bewirken. Dazu sollte ein SEO-Audit durchgeführt werden – eine Bedarfsanalyse, die von den Kosten i.d.R. gering ist und den aktuellen Stand im Bereich SEO festhält.

Nach der Analyse der Seite können die Aufgaben priorisiert und nach und nach abgearbeitet werden. So können die laufenden Kosten gering gehalten werden und trotzdem geht es mit der Sichtbarkeit in den Suchmaschinen voran.

Wie hoch das Budget für SEO im Einzelnen sein muss, hängt stark vom Ist-Zustand der Website ab. Bestimmte Arten von Websites bekommen z.B. mehr oder weniger von alleine ständig neue Links von anderen Webseiten. In dem Fall ist die oft aufwendige Offpage-Optimierung mit wenig Aufwand zu bewerkstelligen. Technologieunternehmen müssen oft im technischen Bereich mit ihrer Webseite glänzen. So kann sich hier der Aufwand für Optimierungsmaßnahmen im Bereich Page Experience gering halten, weil bereits viel erledigt ist. Oder ein Unternehmen mit einem eigenen Redaktionsteam brauchen nur eine Schulung im Bereich Content-SEO und könnte danach quasi selbständig die Inhalte grundlegend optimieren.

SEO Tools

Website Analyse Tools gibt es wie Sand am Meer. Zum Einstieg sollte man die kostenlosen SEO Tools, z.B. den SEO DIVER von ABAKUS, nutzen, um eine Übersicht auf den SEO Status seiner Domain zu erhalten. Oft sind sie einfach gehalten und erleichtern so Einsteigern das Verständnis deutlich.

Die bereits angesprochenen Webmaster Tools bilden die Grundlage. Für viele verschiedene Zwecke bietet Google Lösungen an. Allerdings muss man auch sehen, dass Google Tools herausbringt, um Seitenbetreiber in eine gewisse Richtung zu bringen. Die Backlink-Analyse ist bei Google z.B. eher selten ein Thema. Allerdings machen Backlinks im Ranking bei Google mehr als 50% aus.

Man kann sich bei den zahlreichen Tools am Markt leicht verlaufen und verliert den Blick fürs Wesentliche. Welche Kennzahlen (KPIs) braucht der SEO? Rankings für die Top 20 Suchbegriffe, die aktuellen Traffic-Quellen, ggf. im Vergleich zum vorherigen Zeitraum, die Anzahl der verlinkenden Webseiten bzw. die Anzahl der Nutzer-bringenden Webseiten. Jede Website hat ein Ziel, also brauche ich die Zahlen bzgl. der Abschlüsse/Conversions.

Was davon kann mir mein Webanalytics Matomo liefern? In Matomo habe ich die Möglichkeiten Daten aus der Google Search Console anzeigen zu lassen. So habe ich den Suchbegriff, die Anzahl der Klicks, die Anzahl der Einblendungen, die Klickrate und die durchschnittliche Position in meinem Webanalytics und kann mir auch den zeitlichen Verlauf anzeigen lassen und z.B. über ein selbst erstelltes Segment den Marken-Traffic herausfiltern.

Die aktuellen und auch historischen Traffic-Quellen sehe ich unter dem Punkt Akquisition und kann über verschiedene Segmente filtern. Bei den verlinkenden Websites sehe ich in Matomo lediglich die Webseiten, die Klicks gebracht haben. Es ist aber grundsätzlich möglich über die Majestic SEO API die bestehenden Links einer Domain zu zeigen.

Der Bereich „Ziele“ ist in Matomo recht übersichtlich. Wenn man ein neues Ziel definiert hat man verschiedene Möglichkeiten, z.B. kann das Aufrufen einer bestimmten URL als Ziel definiert werden oder wenn eine Datei heruntergeladen oder eine andere Aktion durchgeführt wurde. Auch die Sitzungslänge, also Verweildauer kann als Ziel angegeben werden.

Zusätzlich lassen sich Server-Logfiles in eine zusätzliche Property laden und so weitere Erkenntnisse über die eigene Webseite erlangen.

Durch die Konzentration auf ein Backend lässt sich die für die SEO Analyse aufgewendete Zeit deutlich reduzieren. Für bestimmte SEO-relevante Punkte braucht man allerdings zusätzliche SEO Tools. Die Keyword-Recherche kann kostenlos über den SEO DIVER erfolgen. Technische Analysen können gut über Google-eigene Tools erledigt werden.

Im professionellen SEO Agentur-Alltag setzen wir neben unseren eigenen SEO Tools aus dem SEO DIVER auch Sistrix, Majestic SEO, Semrush und ahrefs ein. Ein wichtiges Browser Addon ist die Web Developer Toolbar. Das beste SEO Tool ist Brain 1.0.

On-SERP SEO

Durch immer mehr Arten von Sucherergebnissen bei Google bieten sich dem SEO immer mehr Inhaltsbereiche, die optimiert werden können. Und so ist auch die On-SERP Optimierung (On-SERP SEO: Optimierung für die erste Suchergebnisseite (SERPs=Search Engine Result Pages), um die Sichtbarkeit der eigenen Marke zu maximieren) ein weiteres Feld in der Suchmaschinenoptimierung.

Der Google Knowledge Graph bzw. das Knowledge Panel, das local Pack, Sitelinks und Snippet Links, verwandte Suchanfragen, featured Snippets u.a. SERP Features steigern nicht nur die Sichtbarkeit, sondern auch die Interaktionsrate beim Nutzer.

Durch das zur Verfügung stellen von Informationen und Inhalten reichert der Seitenbetreiber die Google Suchergebnisse an und liefert so einen Mehrwert. Nur, wenn der Seitenbetreiber die vom User erwarteten Inhaltsarten liefert, kann er an dieser Stelle den Nutzer für sich gewinnen und kommt mit ihm in den ersten Kontakt. Ob das ein Video ist oder etwa Produktinformationen, die mit strukturierten Daten ausgezeichnet sind, hängt von der Suchphrase und der damit einhergehenden Suchintention ab.

Onpage-Optimierung

Die Onpage-Optimierung grenzt sich klar von den weiteren Bereichen Offpage-SEO und Onsite-SEO ab. Die Onpage-Optimierung betrifft alle redaktionellen Inhalte. Das fängt beim Title und der Meta Description an und setzt sich im Text und weiteren Inhaltsarten fort. Bei der Conversion Optimierung gibt es Überschneidungen. Offpage-SEO ist alles, was nicht auf der eigenen Domain passiert und ggf. auch nicht vom Seitenbetreiber beeinflusst werden kann. Es geht auch ein Stück weit um die Reputation der Domain bzw. des Unternehmens. Onsite-SEO umfasst die Programmierung der Webseite, die Gestaltung der Templates. Der Website-Entwickler kann zum Beispiel über bestimmte Maßnahmen die Page Experience sitewide verbessern. Die redaktionelle Optimierung soll die Relevanz des jeweiligen Dokuments steigern und dem Nutzer Inhalte liefern, die seiner Suchintention entsprechen.

Offpage-Optimierung

Offpage-Optimierung bedeutet, dass man als Seitenbetreiber dafür sorgt, dass über Partnerschaften Nutzer auf die eigene Webseite kommen. In der Website-Bewertung durch Google spielen externe Faktoren eine gewichtige Rolle. Mehr als 50% des Rankings bei Google sollen durch Offpage-Faktoren bestimmt werden. Man kann also auf seiner Webseite schreiben was man will, solang es nicht auf anderen Webseiten bestätigt wird, ist es nicht ganz glaubwürdig für Google. Daher sollte man über verschiedene Maßnahmen an der Reputation arbeiten. „Wissen teilen, Kompetenz zeigen“ ist der Wahlspruch von ABAKUS.

Es gibt viele Möglichkeiten Links zur eigenen Domain zu erzeugen. Wichtig ist, dass der Nutzer einen Mehrwert dadurch hat. Die besten Links sind die „natürlichen“. Durch das Erstellen mehrwertiger Inhalte bekommt die Webseite ohne eigenes Zutun Links von anderen Domains, die thematisch ähnlich sind.

Onsite-Optimierung

Per Definition ist die Onsite-Optimierung der technische Teil der Suchmaschinenoptimierung. Template-Strukturen, Verlinkungslogik, Ladezeit, bzw. Page Experience bzw. Core Web Vitals u.a. Punkte werden hier verbessert. Auch die Steuerung der Indexierung (Wie führe ich die Robots durch meine Seite?) gehört dazu.

Wenn die Technik zuverlässig ist, kann Google auch viel Traffic schicken. Für die Suchmaschine ist Zuverlässigkeit wichtig, ebenso wie Schnelligkeit in der Auslieferung der Seiten.

Marktanteile der Suchmaschinen

Verschiedene Datenquellen liefern unterschiedliche Zahlen zur Marktsituation in der Internetsuche. Aktuell ist es aber noch so, dass Google Marktführer in Deutschland, Österreich und der Schweiz ist. Aber es ist Bewegung im Markt. Fragen, die Google nicht ausreichend oder nur einseitig beantwortet, werden in anderen Suchmaschinen gestellt. Metager als Meta-Suchmaschine gibt schon einmal einen breiteren Blick auf die Themen. Meta-Suchmaschinen nutzen die Daten anderer Suchmaschinen und kombinieren diese.

Interessant ist immer, sich das Geschäftsmodell einer Suchmaschine anzuschauen, wenn man wissen will, ob sie etwas taugt. Wie kommt z.B. Startpage an die Google Ergebnisse? Nur, weil sie Google Werbung einbinden überlässt der Internetriese ihnen die Daten? Und so nutzt Ecosia die Bing Daten usw. Ob man Qwant aus Frankreich oder Swisscows aus der Schweiz nutzt ist Geschmackssache. Wenn aber ein Marktteilnehmer einen zu großen Anteil erlangt, geraten Unternehmen und Nutzer in eine Abhängigkeit. Weitere Beispiele für alternative Suchmaschinen sind Duckduckgo, Yandex, Search.ch. Über Lycos oder Fireball braucht man heutzutage wohl nicht mehr reden.

Liste relevanter Suchmaschinen für Deutschland

- Bing

- Duckduckgo

- Ecosia

- Metager

- Qwant

- Search.ch

- Startpage

- Swisscows

- Yahoo

SEO Lexikon

Ein Lexikon ist in jedem Fachbereich eine gute Möglichkeit die Site-interne Verlinkung zu optimieren und hilft Einsteigern bei der Einführung in ein Thema. 80% der Suchanfragen im Internet sind „informational“ und mit SEO mit einem Lexikon schafft man auf der eigenen Webseite mehrwertige Inhalte. Das Lexikon kann über die Monate und Jahre wachsen und immer wieder aktualisiert werden. Durch eine durchdachte Nutzerführung kann der User aus dem informativen in den kommerziellen Bereich gebracht werden oder es wird ein Newsletter beworben o.ä. Es gibt noch andere Beispiele, um die interne Verlinkung zu verbessern. Eins ist die Nutzung von Tags, bzw. Tagseiten. Diese sollten allerdings auf „noindex“ gesetzt werden. So kann man die interne Verlinkung unterstützen, läuft aber nicht Gefahr, dass diese inhaltlich geringen Seiten ins Ranking kommen. Der Vorteil an Tagseiten ist, dass die interne Verlinkung quasi automatisch passiert. Für wichtige Seiten sollte diese aber auch manuell nachgebessert werden.

Mit solch einem Ratgeber kann man die Nutzer bereits früh in der Informationsphase abholen und an sich binden. Im Internet sind Ø 8 Kontakte nötig, um den Nutzer zum Kunden zu machen. Mit fachlichen Definitionen zeigt man zum einem Kompetenz, zum andern kann die Webseite so kontinuierlich wachsen.

Lokale Optimierung

Für viele kleine und mittelgroße Unternehmen (KMU) ist es von Vorteil, wenn sie online präsent sind. Umgekehrt zeigt sich nämlich, dass ein Großteil der KMU, die in den letzten Jahren schließen mussten, keine oder eine recht schlechte Online Präsenz hatten. In welchem Umfang sich das Unternehmen online präsentiert hängt von der Branche, der Zielgruppe und den Ressourcen ab. Ein Szenelokal in München braucht sicher Facebook, Instagram und Tumblr, um bei der Klientel gut anzukommen. Für einen Bioladen in Springe bei Hannover reicht wohl schon eine ausführliche Liste der Produkte, weil es nur drei Wettbewerber vor Ort gibt. Aber die lokale Suchmaschinenoptimierung bietet natürlich noch mehr Möglichkeiten, um als kleines Unternehmen online sichtbar zu sein. Neben Google MyBusiness sollten verschiedene Branchenbücher genutzt werden, um Reichweite zu erzeugen. Ein Trend in der Internetsuche ist, dass vertikale Suchsysteme, also auch Branchenbücher, häufiger genutzt werden. Portale wie Facbook, meinestadt, bing oder golocal habe selbst teilweise eine riesige Reichweite. Zusätzlich werden die Datensätze auch von anderen Diensten genutzt und das Unternehmen taucht so beispielsweise im Navi des Autos auf und so ist der Eintrag im Branchenbuch doppelt nützlich.

Keyword-Recherche

Obwohl die Keyword-Recherche der Startpunkt im SEO ist, wird dieser wichtige Punkt erst jetzt thematisiert. Zuerst sollte ein grober Überblick und die Einführung in die Suchmaschinenoptimierung geschaffen werden, bevor es „Hands on“ geht.

Beim Start von SEO Projekten gibt es verschiedene Ausgangssituationen. Gibt es die Domain schon länger und sie wurde bisher nur nicht optimiert oder ist es ein ganz neues Projekt? Bei bestehenden Projekten kann man über die Auswertung verschiedener Tools, wie Ahrefs, Semrush oder den Webmaster Tools wichtige Informationen zu den relevanten Suchbegriffen erhalten. Diese ersten Daten kann man als Brainstorming ansehen. Zuvor sollte der Seitenbetreiber allerdings eine Seedlist erstellen. In diese gehören die fünf wichtigsten Suchbegriffe für die betreffende Domain. Wenn die Begriffe der Seedlist nicht in den Daten der Webmaster Tools vorhanden sind, liegt das sicher daran, dass die noch nicht optimierte Domain keine Sichtbarkeit für diese Begriffe hat. Aber das kommt noch. Um das Suchvolumen je Begriff zu ermitteln nimmt man einfach ein kostenloses Tool, wie z.B. das Sistrix Keyword Tool.

Für ein komplett neues Projekt sollte man ein kostenpflichtiges Tool nutzen, z.B. Ahrefs.com, Searchmetrics oder Semrush oder man investiert in eine Beratung durch eine SEO Agentur. Die Fachleute sind versiert und unterstützen solche SEO Projekte mit einem breiten Blick und ausreichend Erfahrung. Der Traffic über Suchergebnisse wird so sicher nach oben gehen.

Mit den Daten aus dem einen oder anderen Tool sollte man auf eine erste grobe Auswahl von mind. 50, max. 150 potenziellen Suchbegriffen kommen. Diese werden dann qualifiziert. Am Ende braucht man eine Liste von ca. 20 Suchbegriffen, die man nach und nach optimieren kann. Das Suchvolumen ist eine einfache Entscheidungshilfe, die Intention des Nutzers sollte aber letztendlich die Entscheidung bringen. Nur, wenn diese bedient werden kann, sollte der Begriff gewählt werden. Eine weitere Entscheidungshilfe ist, ob es sich um einen kommerziellen Begriff handelt. Es wird weniger Wettbewerb geben, aber es wird höchstwahrscheinlich auch von Wettbewerbern optimiert.

Es wird immer Suchbegriffe geben, die in verschiedenen Schreibweisen existieren, z.B. „Keyword-Recherche“. Ist es „Keyword-Recherche“ oder „Keywordrecherche“ oder „Keyword Recherche“? Zwei entscheidende Punkte gibt es hier: die akkurate Rechtschreibung und die Sprache der Nutzer. Wenn die exakte Suchphrase auf der eigenen Seite zu finden ist, bietet das einen Vorteil im Ranking. Es geht um die exakte Zeichenkette und ein Bindestrich ist kein Leerzeichen. Deshalb ist im SEO die Auswahl der Suchbegriffe von großer Bedeutung. Allerdings kann im Laufe der Zeit, wenn weitere Erkenntnisse gemacht wurden, die Onpage-Optimierung geändert werden.

Duplicate Content

Der sog. Duplicate Content entsteht, wenn auf zwei unterschiedlichen URLs ein und derselbe Text vorhanden ist. Dabei gibt es zwei Möglichkeiten. Bei der ersten wird der Inhalt auf der eigenen Domain zweifach oder gar mehrfach unter verschiedenen URLs veröffentlicht. Wenn das unumgänglich ist, kann man hier mit dem Canonical Tag arbeiten und Google so darauf hinweisen, dass es eine bestimmte URL gibt, die mit diesem Inhalt ranken darf. Die zweite Möglichkeit ist, dass der eigene Inhalt auf einer fremden Domain veröffentlicht wurde. Ob das rechtens ist, muss im Einzelfall geprüft werden. Da hat man dann erst einmal die Möglichkeit sich mit dem Seitenbetreiber oder Webmaster in Verbindung zu setzen – es sei denn, es handelt sich um Spam. In dem Fall kann man nur seinen eigenen Inhalt erweitern, um den Duplicate Content zu entschärfen. Glücklicherweise wird Google in solch einem Fall die Domain ranken lassen, die den Inhalt als erstes veröffentlicht hat. Der Urheber hat also grundsätzlich hier den Vorteil.

Near duplicate Content besteht, wenn Teile des Inhalts auf weiteren URLs veröffentlicht werden. Ein gängiges Beispiel ist es, wenn z.B. Texte von Wikipedia übernommen und/oder teilweise umgeschrieben werden.

Google prüft Texte in sog. Shingles. Es werden Gruppen von drei Wörtern geprüft, dann, ein Wort weiter nach rechts, werden wieder drei Wörter geprüft, ob sie an anderer Stelle im Internet gefunden wurden. Wenn man sich an fremden Texten orientiert, um gut rankende Inhalte zu erstellen, muss man diese fremden Inhalte mit seinen eigenen Worten wiedergeben.

Mit Copyscape.com oder siteliner.com kann man im Internet nach Kopien der eigenen Inhalte suchen. Oder man kopiert eine Phrase von der eigenen Seite und sucht sie in Anführungszeichen bei Google.

SEO Beratung

Die SEO Beratung durch eine professionelle Agentur ist der einfachste Weg, um sich Wissen und Praxiserfahrung anzueignen. Allerdings sollte man bereits die Grundlagen der Suchmaschinenoptimierung verinnerlicht haben. Nur so kann die SEO Agentur auf Augenhöhe kommunizieren.

Die SEO Beratung kann allgemein gehalten sein oder spezifische Bereiche fokussieren. Der Kunde hat bestimmte Vorstellungen, wenn er eine SEO Beratung beauftragt. Die SEO Agentur sollte der Sorgfaltspflicht halber prüfen, ob die gewünscht Beratung dem SEO Kunden wirklich weiterhilft oder ob es andere / weitere Bereiche des SEO gibt, die der Domain nützen würden.

Es sollte z.B. immer der Offpage-Bereich geprüft werden. Wenn eine Domain bei Google kaum sichtbar ist, wurde oft im Linkaufbau zu wenig oder zu viel getan.

Genauso müssen technische Probleme ausgeschlossen werden. Wenn die Sichtbarkeit mit einem Schlag weg war könnte der Grund z.B. ein Google Update gewesen sein oder die Seite wurde gehackt und es ist noch niemandem aufgefallen.

Bei der inhaltlichen Prüfung hilft ein Blick auf die Wettbewerber. Inhaltlich und umfänglich sollte die Domain so aufgestellt sein, dass sie eine Rankingberechtigung hat. Das wird zum einen über Signale von außen, aber auch durch die Texte, Bilder, Videos usw. auf der Webseite beeinflusst und gesteuert.

Ob die SEO Beratung telefonisch, bzw. per Videokonferenz oder in schriftlicher Form erfolgt ist grundsätzlich gleich, wenn alle beteiligten Abteilungen und Verantwortlichen die Informationen erhalten. Die umfangreichste SEO Beratung stellt der SEO Workshop dar.

SEO Workshop

Der SEO Workshop bringt das Wissen ins Haus. Basis des Workshops sind oft spezielle Kundenwünsche sowie eine Bedarfsanalyse der betreffenden Domain. Innerhalb mehrerer Stunden werden bestimmte Punkte, die vorab analysiert wurden, vorgestellt und im Team besprochen. Jedes Thema kann theoretisch einen ganzen Tag füllen.

SEO als Vertriebskanal

Vertrieb und Marketing sollten heutzutage eine einzige Abteilung im Unternehmen sein. Fachleute sind trotzdem nötig. Ein guter Online Marketing Manager ist nicht immer ein guter Vertriebler. Diese beiden Fachleute sollten Hand in Hand arbeiten. Der Vorteil bei SEO ist – ganz klar – dass der Bedarf beim Kunden bereits entstanden ist, er muss nur noch vom Angebot überzeugt werden.

Zusammenfassung

Die ersten Webkataloge, wie die „Virtual Library“ von Tim Berners-Lee, wurden entwickelt, bevor Suchmaschinen populär wurden. Diese Kataloge ermöglichten es, Inhalte zu indexieren und durchsuchbar zu machen. Das Crawling, ein zentraler Prozess in der Suchmaschinenoptimierung, erfolgt durch Software, die Webseiten über Hyperlinks findet und indexiert. Die Steuerung der Indexierung erfolgt unter anderem über die robots.txt-Datei.

Domains spielen eine wichtige Rolle, da sie die Internetadressen darstellen, unter denen Webseiten gespeichert sind. Während die Domainnamen für SEO nicht direkt relevant sind, sind sie für die Markenbildung von großer Bedeutung. Die Kommerzialisierung des Internets hat die Bedeutung von SEO für Unternehmen erhöht, da Sichtbarkeit im Internet entscheidend für den Geschäftserfolg ist.

Die Entwicklung von SEO-Methoden begann bereits in den 1990er Jahren, als Webentwickler Strategien suchten, um die Sichtbarkeit ihrer Webseiten zu erhöhen. Zu den frühen Techniken gehörte die Verwendung von Meta-Elementen im Quelltext, die den Suchmaschinen helfen sollten, den Inhalt zu erfassen. Im Laufe der Zeit haben sich die Kriterien für die Bewertung von Webseiten durch Suchmaschinen weiterentwickelt, wobei heute auch das Nutzerverhalten eine Rolle spielt.

Spamming, das als Black Hat SEO bezeichnet wird, stellt einen Missbrauch von Techniken dar, um ein besseres Ranking zu erzielen. Die Suchmaschinenbetreiber haben kontinuierlich Maßnahmen ergriffen, um solche Manipulationen zu verhindern. Technische Suchmaschinenoptimierung war ursprünglich der Schwerpunkt, wobei die Content-Optimierung als zentraler Aspekt gilt.

Die Grundlagen von SEO umfassen die Optimierung von HTML-Elementen wie Titles, Meta Descriptions und Überschriften. Diese Elemente sind entscheidend, um die Relevanz einer Webseite zu betonen und die Nutzer anzusprechen. Die inhaltliche Optimierung hat sich von der Keyword-Dichte hin zu einer ganzheitlicheren Betrachtung der Verteilung von Suchbegriffen im Text entwickelt.

Fazit: Was ist SEO?

Mit SEO bezeichnet man Maßnahmen zur Optimierung einer Webseite für die organischen Webergebnisse und andere vertikale Suchen. SEO lässt sich aus vielen verschiedenen Blickwinkeln betrachten. Es gibt kaum eine andere Online Marketing Disziplin, die so vielschichtig ist und so nachhaltig.