Googlebot erklärt

Der Googlebot durchsucht das Web und sammelt für Google die benötigten Informationen, um daraus einen Suchindex zu erstellen, aus dem wiederum das Google Ranking generiert wird. Die beiden wichtigsten Googlebots sind:

- Googlebot Smartphone: simuliert einen User auf einem mobilen Endgerät.

- Googlebot Desktop: simuliert einen Desktop-Nutzer.

Der Googlebot Smartphone ist dabei der primäre Crawler: Der Mobile-First-Index bestimmt maßgeblich den Erfolg Ihrer Website.

- Googlebot: Crawling, Indexierung und Ranking

- Für den Googlebot optimieren

- Googlebot: Indexierung beantragen

- Fazit

Googlebot: Crawling, Indexierung und Ranking

Fachleute verstehen unter einem Crawler eine Software, die von einem Bot gesteuert, automatisiert das Internet durchsucht. Dabei speichert der Crawler Webseiten und extrahiert Links. Er nutzt Algorithmen, um zu entscheiden, welche Seiten er in welcher Häufigkeit crawlt. Der Googlebot ist der spezielle Crawler von Google. Das Google Ranking entsteht dabei in drei Stufen:

- Crawling: Die Googlebots durchsuchen das Internet nach neuen Seiten, verarbeiten diese und fügen sie dem Suchindex hinzu. Die Bots crawlen Seiten in bestimmten Zeitabständen mehrfach, um Änderungen zu erfassen. Dabei folgen sie den Links und springen so von Website zu Website. So finden sie neue und aktualisierte Inhalte, die sie dem Suchindex hinzufügen. Googlebots nutzen die Sitemap und die robots.txt-Datei, um effizient zu crawlen. Bots crawlen gut erreichbare und regelmäßig erneuerte Seiten dabei häufiger.

- Indexierung: Die beim Crawling gefundenen Seiten werden bei der Indexierung gespeichert und analysiert. Der Googlebot bewertet anhand von Signalen wie Relevanz, Qualität und Aktualität die Inhalte Ihrer Seite. Danach entscheidet Google, ob die Seite in den Google-Index kommt oder nicht. Google prüft auf Duplikate und die Einhaltung von inhaltlichen Mindeststandards. Der Googlebot ruft die Inhalte einer Seite ab und rendert die Seite. Er führt gefundenes JavaScript aus und sieht die Website dann so, wie User sie auch sehen.

- Ranking: Der komplexe Google-Algorithmus bewertet die indexierten Seiten. Viele verschiedenen Qualitätsfaktoren wie Inhalt, technische Umsetzung, Ladezeit, Backlinks oder Aktualität finden dabei Berücksichtigung. Anschließend erscheinen die Seiten dann in einer Reihenfolge sortiert auf den Google Suchergebnisseiten (SERPs).

Für den Googlebot optimieren

Sorgen Sie dafür, dass der Googlebot Ihre Seite regelmäßig crawlt und unterstützen sie ihn durch folgende Maßnahmen:

- XML-Sitemaps nutzen: Reichen Sie eine Sitemap ein und legen Sie die zu crawlenden bzw. zu indexierenden Seiten fest. Viele CMS verfügen über Erweiterungen oder Plugins, die automatisch Sitemaps generieren. In der XML-Sitemap finden die Bots nicht nur die URLs, sondern auch zusätzliche in den Metadaten enthaltene Informationen über die jeweiligen Seiten.

- gute interne Verlinkung: Erleichtern Sie den Bots das Finden Ihre Unterseiten durch interne Verlinkungen.

- korrekte robots.txt: Steuern Sie mit der robots.txt-Datei das Crawling Ihrer Website-Inhalte. Über Anweisungen teilen Sie dem Bot mit, welche Seiten gecrawlt bzw. nicht gecrawlt werden sollen Checken Sie Ihre robots.txt regelmäßig auf Korrektheit. Die robots.txt-Datei regelt die Crawlerbesuche auf Ihrer Website und verhindert so eine Überlastung mit Anfragen. Mit robots.txt-Regeln verwehren Sie den Crawlern den Zugriff auf bestimmte Seiten, um den Fokus auf wichtigere Bereiche Ihrer Website zu lenken. Mit der robots.txt schließen Sie für Google private Seiten (Login-Bereich), duplizierte Seite und irrelevante Seiten aus. Im SEO DIVER sehen Sie im Dashboard bei Klick auf das Dokumenten-Icon die Veränderungen Ihrer robots.txt-Datei im Zeitverlauf. Registrierte Nutzer bekommen nach Einstellung eines Alerts bei Änderung der robots.txt eine E-Mail vom SEO DIVER.

- übersichtliche Website-Struktur: Eine gute Struktur vereinfacht das Crawling.

- keine fehlerhaften ausgehenden Links: Vermeiden Sie, dass die Crawler kaputten Links folgen und dann auf einer Fehlerseite landen: Checken Sie daher regelmäßig Ihre ausgehenden Links. Nutzen Sie unseren Broken Link Checker, um Ihre ausgehenden Links zu überprüfen.

- begrenzte Anzahl an Redirects: Bereinigen Sie mehrfache Weiterleitungen, die den Crawlern nur unnötige Arbeit bescheren. Kontrollieren Sie daher die Weiterleitungen in Ihrer .htaccess-Datei.

- regelmäßige Kontroll-Crawls: Crawlen Sie Ihre Seiten regelmäßig mit SEO Tools und korrigieren Sie auftretende Fehler.

- Robots-Meta-Tags verwenden: Fügen Sie Robots-Meta-Tags in den Head Ihrer Website ein, um zu steuern, wie einzelne Seiten gecrawlt, indexiert oder angezeigt werden sollen. Mit seitenspezifische Anweisungen (noindex) teilen Sie den Bots mit, welche Seiten gecrawlt werden dürfen (oder nicht). Mit noindex verhindern Sie die Indexierung Ihrer Seite, während Sie mit nofollow die Verfolgung der ausgehenden Links deaktivieren.

- alt-Tags und strukturierte Daten hinzufügen: Erleichtern Sie dem Googlebot die Arbeit und fügen Sie alt-Tags für Ihre Grafiken und strukturierte Daten für Inhalte hinzu.

- Mobilfreundlichkeit: Optimieren Sie die mobile Version Ihrer Website, damit vom Googlebot Smartphone indexiert zu werden.

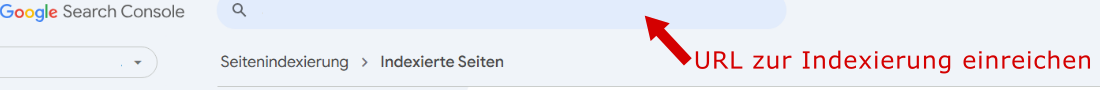

Googlebot: Indexierung beantragen

Gehen Sie in der Google Search Console auf Indexierung-Seiten. Sie sehen nun die Gesamtzahl Ihrer indexierten Unterseiten. Laden Sie sich oben rechts unter EXPORTIEREN eine Übersicht aller indexierten Seiten runter. Checken Sie, wann der Googlebot Ihre jeweiligen URLs zuletzt gecrawlt hat. Geben Sie oben eine URL zur erneuten oder erstmaligen Indexierung ein. Normalerweise crawlt der Googlebot dann innerhalb weniger Stunden Ihre eingereichte Seite.

Fazit

Der Googlebot bildet die Basis der Google-Suchmaschine und entscheidet über die Indexierung Ihrer Website. Erleichtern Sie dem dem Bot durch gezielte Maßnahmen das Crawling und die Indexierung, so verbessern Sie Ihre Google Rankings.

Anzeige