Index Bloat erklärt

Viele von Ihnen kennen das Problem: Für Ihr Unternehmen (aber offensichtlich nicht für Google) wichtige Unterseiten Ihrer Website befinden sich nicht im Google-Index. Deutlich weniger bekannt ist das gegenteilige Phänomen namens Index Bloat: Der Index ist aufgebläht (bloat) und enthält Unterseiten, die für Ihren Online-Erfolg nicht wichtig sind und Ihr Crawl-Budget belasten.

Welche Seiten sollte Google nicht indexieren?

Nicht im Index enthalten sein sollten:

- Session URLs: Bei jedem Visit startet eine neue Session und ein Parameter mit der Session-ID wird der URL hinzugefügt. So entstehen sehr viele verschiedenen URLs für den identischen Content, obwohl der Inhalt immer gleich bleibt. Die Suchmaschinenbots indexieren dann viele Duplikate.

Beispiel-URL: https://www.abc.de/seite?sessionid=fasr84e18d

Bei Speicherung der Session-ID in einem Cookie verändert sich die URL nicht. So vermeiden Sie unnötige, nicht für den Google Index bestimmte URLs. - Faceted URLs entstehen in Onlineshops durch die Suche nach Facetten (Varianten). Beispiel: Sie suchen in einem Webshop nach einem Sportschuh und erhalten eine Ergebnisliste mit allen vorrätigen Sportschuhen. Dann filtern Sie nach Größe, Farbe und so weiter. Durch jede Filterung ändert sich die URL um eine Facette. Neue URLs mit den ausgewählten Attributen als Parametern werden erzeugt. Schließen Sie beispielsweise in der robots.txt die betroffenen URLs vom Crawling aus. Oder nutzen Sie den canonical-Tag, um die Indexierung der facettierten Seiten zu vermeiden. So erhält die URL mein-shop.de/produkte/sportschuhe?groesse=43 den canonical-Tag mein-shop.de/produkte/sportschuhe. Nach diesem System schließen Sie die durch die Filterung entstehenden URLs von der Indexierung aus.

- Internationale Seiten mit sehr ähnlichen Sprachversionen. Haben Sie eine Seite für Österreich und eine für Deutschland unterscheiden diese sich vermutlich kaum. Durch den hreflang-Tag zeigen Sie den Suchmaschinen welchen regionale Version für den jeweiligen User relevant ist.

- Duplicate Content durch Fehler in der Behandlung von www und nicht www-Seiten bzw. falsche http zu https Weiterleitungen. Überprüfen Sie Ihre .htaccess-Datei auf Fehler und vermeiden Sie unkorrekte Weiterleitungen. Ansonsten sind unter Umständen zwei Versionen (http und https) Ihrer Website erreichbar.

- Suchergebnisseiten Ihrer internen Suche mit eigenen URLs. Setzen Sie Ihre interne Suchseite auf noindex oder verhindern Sie das Crawling der Seite mit der robots.txt-Datei.

Das Crawl-Budget sinnvoll nutzen

Das Hauptproblem bei zu vielen indexierten Seiten liegt darin, dass Google viele Seiten crawlt, die nicht relevant sind. Dann nutzt Google das Crawl-Budget (aus Sicht des Seitenbetreibers) nicht optimal aus. Unter Umständen indexiert Google dann neue oder wichtige Unterseiten mit Verspätung oder gar nicht. Deindexieren Sie daher bestimmte Seiten, um das Crawl-Budget optimal auszunutzen und Ihre wichtigen Seiten mit Priorität indexieren zu lassen.

Vermeiden Sie außerdem, dass Ihre Seiten sich kannibalisieren und für ein Keyword mehrere Ihrer Seiten im Index sind. Sind qualitativ minderwertige Unterseiten erst gar nicht im Index, verhindern Sie in vielen Fällen das Kannibalisierungproblem.

Verlinken Sie von den für Sie unwichtigen Unterseiten auf die relevanten Seiten, so stärken Sie die wichtigen URLs. Seiten mit identischen oder sehr ähnlichen Inhalten (Duplicate Content) sind für das Gesamtranking Ihres Webauftritts problematisch. Setzen Sie auch hier auf canonical-Tags zur Vermeidung doppelter Indexierungen. Selbstverständlich besteht auch die Möglichkeit, diese Seite per noindex aus der Indexierung zu entfernen.

Neben Duplicate Content ist auch Thin Content ein Problem. Schließen Sie daher Unterseiten, die Ihren Usern keinen Mehrwert bieten von der Indexierung aus. Schließlich werten Suchmaschinen Thin Content ab. Außerdem verlassen Nutzer diese Seiten schnell wieder, dann steigt die Absprungrate und die Verweildauer sinkt. Qualitativ schlechte oder inhaltlich dünne Unterseiten beeinflussen das Ranking der gesamte Seite negativ.

In der Google Search Console erscheint manchmal die Meldung „Gecrawlt – zurzeit nicht indexiert“. Die Unterseite muss dann nicht nochmals zur Indexierung eingereicht werden. Googles Kapazitäten sind begrenzt, die Suchmaschinen indexiert nicht alle Seiten sofort. Manchmal braucht die Bewertung und anschließende Einordnung der Seiten anhand der Rankingkriterien etwas länger.

Beachten Sie: Googles Helpful Content System gilt für alle Unterseiten. Einzelne minderwertige Unterseiten verschlechtern die Gesamtbewertung und senken die Glaubwürdigkeit. Die Fokussierung auf hochwertige Inhalte steigert somit Ihre gesamte Seitenqualität.

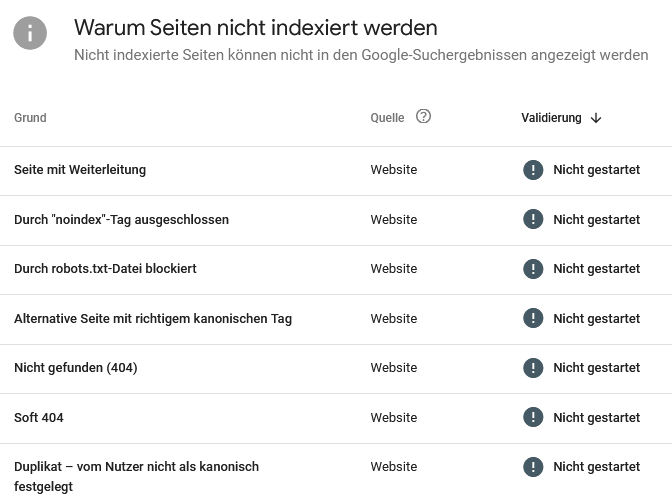

Den Indexierungsstatus regelmäßig prüfen

Überwachen Sie den Status Ihrer Website in der Google Search Console, um Indexierungsprobleme zu vermeiden. Die GSC zeigt Ihnen die Anzahl Ihrer indexierten Seiten an. Reagieren Sie, falls unwichtige Seiten indexiert sind oder relevante Seiten fehlen. Regelmäßiges Monitoring der indexierten Seiten erspart Ihnen Rankingprobleme. Google zeigt Ihnen nicht nur, welche Ihrer Seiten nicht indexiert sind, die GSC zeigt Ihnen auch die jeweiligen Gründe:

- mit einem canonical-Tag markierte Duplikate.

- nicht gefundene Seiten, die einen 404 Fehler erzeugen.

- durch einen noindex-Tag von der Indexierung ausgeschlossene Seiten

- weitergeleitete Seiten

- …

URLs aus dem Index entfernen

Qualitativ schlechte Seiten enttäuschen die Nutzererwartungen. Die entsprechenden SEO-Kennzahlen zeigen dann niedrige Werte und die User Experience sinkt. Das schadet Ihrer Marke, was gerade für AI-Suchmaschinen eine starke Schwächung Ihrer Wettbewerbsposition bedeutet.

Bedenken Sie: Google bewertet die URLs nicht einzeln, sondern immer im Zusammenhang mit allen vorhandenen URLs einer Webpräsenz. Das Ziel ist also nicht unbedingt, sämtliche URLs in den Index zu bringen, sondern alle wertigen Seiten indexieren zu lassen.

Deindexieren Sie Ihre Seiten, indem Sie den Status der URL auf 410 „Gone“ setzen. Checken Sie vor der Entfernung mit einer Backlinkanalyse, ob wertvolle Links auf die Domain verweisen. Löschen Sie die URLs ohne den Status auf 410 zu setzen, erscheint der HTML-Status 404, der nur eine vorübergehende Seitenentfernung oder Nicht-Erreichbarkeit bedeutet. Nur der Statuscode 410 signalisiert eine absichtliche Entfernung der Seite und zeigt den Suchmaschinen, dass eine Indexierung der URL nicht erwünscht ist.

Wollen Sie eine Seite aus dem Index entfernen und durch eine themenverwandte URL ersetzen, dann richten Sie eine 301 Weiterleitung auf die themenverwandte URL ein. Durch dieses Vorgehen bleibt der Linkjuice der ursprünglichen URL erhalten.

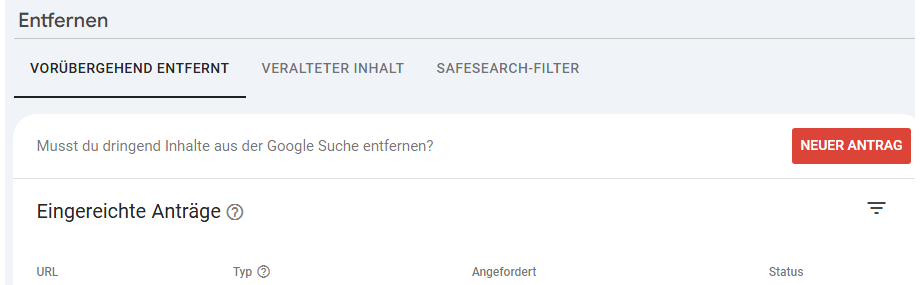

Nutzen Sie außerdem das URL Remove Tool von Google in der Google Search Console, um URLs schnell aus dem Index zu entfernen.

Wichtige URLs fehlen im Index

Einige mögliche Gründe dafür, dass wichtige URLs nicht im Index sind:

- Eine falsch konfigurierte robots.txt-Datei oder versehentlich gesetzte noindex-Tags verhindern die Indexierung.

- Mangelnde inhaltliche Qualität oder Duplicate Content sorgen dafür, dass Google die Seiten nicht in den Index aufnimmt.

- Die URLs sind intern und extern zu wenig verlinkt.

- Durch technische Probleme ist die URL zeitweise nicht erreichbar.

- Canonical-Tags signalisieren, dass andere URLs indexiert werden sollen.

- …

Fazit

Eine korrekte Indexierung Ihrer Unterseiten bildet die Basis für Ihren Erfolg in Suchmaschinen. Durch unsere Dienstleistung Index-Optimierung sorgen wir dafür, dass Google Ihre URLs korrekt indexiert. So ermöglichen wir Ihnen gute Rankings in der klassischen Google-Suche, in den AI Overviews und im Google AI Mode. Kontaktieren Sie uns telefonisch unter 0511-3003250 oder per E-Mail an sales@abakus-internet-marketing.de.

Anzeige