SEO und Cyber Security

Warum sich SEOs auch mit Website-Sicherheit befassen sollten

Cyber Security ist auch SEO Thema. Sind Webseite oder Online-Shop durch Angriffe aufgrund zu weniger Sicherheitsmaßnahmen mehrere Tage nicht erreichbar, kann das neben dem Rückgang von Besuchern und Einnahmen auch Einbußen für das vorhandene Google-Ranking bedeuten! In diesem Artikel erfahren Sie, welche Gefahren für Ihre Rankings im Web lauern.

Welche Gefahren lauern für SEOs und Webseitenbetreiber?

Sicherheitslücken können direkten Einfluss auf vorhandene Rankings haben!

Durch den Ausfall der unternehmerischen Webseite und die Kosten der Datenrettung und Wiederherstellung kann ein direkter finanzieller Schaden entstehen. Daneben wird das Vertrauen der Besucher beeinträchtigt und sie kommen oft kein weiteres Mal auf die Webseite.

In direktem Zusammenhang stehen die Auswirkungen auf Ihre vorhandenen Rankings. Es ist sehr wahrscheinlich, dass die Webseite organischen Traffic verliert und weniger Leads generiert. Google hat momentan in Deutschland und in Europa einen Marktanteil von ca. 90%. Wer bei Google verschwindet, verschwindet!

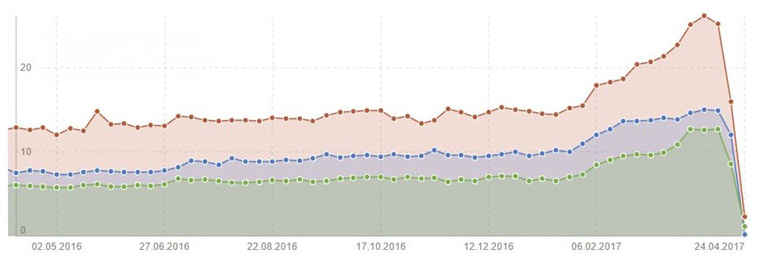

Was können die Folgen eines Hacker-Angriffs im Bereich SEO sein?

- Ranking-Verluste

- Traffic-Einbrüche

- Reputationsschäden

- Ausbleiben von Kundenanfragen

- Umsatzrückgänge

Quelle: Beispielhafter Traffic-Verlust einer Webseite nach Hackerangriff; SISTRIX.de.

Wenn Sie langfristig in Ihre Sichtbarkeit in der Suche investieren, in einem stark umkämpften Markt tätig sind oder stark auf den organischen Verkehr angewiesen sind, ist Wachsamkeit in puncto Sicherheit von entscheidender Bedeutung!

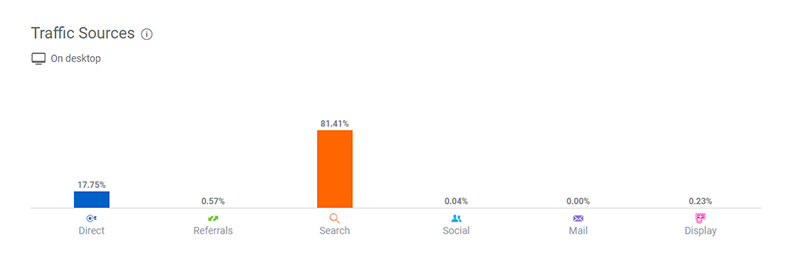

Wie wichtig es für Unternehmen ist, über die Suche gefunden zu werden:

Quelle: similarweb.com, 2019; beispielhafte Traffic-Verteilung.

Die beliebtesten CMS sind auch die am häufigsten attackierten

Die am häufigsten eingesetzten Content Management Systeme sind WordPress, gefolgt von Joomla, Drupal und Typo3. Naturgemäß sind es auch diese Systeme, die im Fokus von automatisierten Angriffen stehen.

Haben Sie selbst in der Vergangenheit Erfahrungen mit Hacker-Angriffen gemacht?

Zum Beispiel auf der eigenen Webseite oder auf Webseiten, die Sie betreuen? Wurde Ihr Online-Shop schon einmal „lahmgelegt“?

Ohne eigenes Verschulden auf die Blacklist

Laut aktueller Studie des Webhosters GoDaddy werden über 70% gehackter Webseiten für betrügerische Zwecke angegriffen. Inhalte werden gescrapt, Malware oder Phishing-Links verbreitet. Die attackierten Websites werden mit Spam überflutet und möglicherweise auf die schwarze Liste gesetzt.

Quelle: Flickr.com vagueonthehow.

Etwa 10% der gehackten Webseiten kommen auf die Blacklist. Darüber hinaus fallen Sanktionen aufgrund eines Nicht-Erkennens oder Nicht-Handelns im Falle einer Hacker-Attacke hart aus.

Hat Google die Gefahr einer Seite für den Nutzer erkannt, bekommt diese keinen Traffic mehr.

Google muss sofort handeln, denn die Suchmaschine kann Nutzer nicht auf gefährliche Seiten schicken!

Was machen die Malicious Bots?

Laut einer aktuellen Symantec-Studie weisen ca. 9% aller Webseiten eine sehr große Sicherheitsanfälligkeit auf.

Ca. 20% der Bots durchforsten Websites zu schändlichen Zwecken, z. B.

- zum Scraping von Inhalten,

- zur Identifizierung von Schwachstellen,

- zum Datendiebstahl,

- oder zur Verbreitung von Spam.

Dem Bot ist es gleich, wie groß Ihre Website ist! Der Roboter geht nach Mustern vor. Sie orientieren sich an bestimmten Merkmalen wie dem Server bzw. an der eingesetzten Software, die eine Schwachstelle wahrscheinlich machen. Veraltete CMS-Versionen und unfertige Installationen sind beliebte Sicherheitslücken.

Die Hacker prüfen anhand von bekannten Pfaden (z.B. /phpMyAdmin/) welche Software eingesetzt wird. Darf der Bot eine solche URL aufrufen, werden mögliche Sicherheitslücken getestet, um Zugang zum Server zu erlangen. Also schon die (einigermaßen kreative) Änderung des Installationspfades bei der Einrichtung bringt etwas mehr Sicherheit.

In dieser ersten Phase prüft der Bot einige Dutzend URLs pro Minute und bleibt so unterm Radar – wird also nicht automatisch vom Server wegen zu vieler Anfragen gesperrt.

Bösartige Bots verursachen Crawl Errors

Schädliche Bots verwenden dieselbe Bandbreite und dieselben Server-Ressourcen wie ein legitimer Bot oder ein normaler Besucher. Wird massiv gecrawlt, könnte Ihr Server durch diese hohe Serverlast möglicherweise die Bereitstellung der Seiten ganz einstellen. Die Ladezeit ist außerdem nach wie vor ein wichtiges Ranking-Kriterium bei Google.

Auch legitime Bots können:

- Bei der Serverlast Spitzen erzeugen, z.B. wenn viele neue Inhalte live gehen.

- Auf Ihrer Website auf einen Fehler stoßen, welche z.B. eine Endlosschleife auslösen.

Es ist wichtig, die Serverstatistiken (Logfiles) regelmäßig auszuwerten.

SEO-Spam

Unter SEO-Spam fallen Content Scraping, schlechte Backlinks, Cloaking und weitere bekannte, negative SEO-Praktiken. Aber auch Malware kann in die selbige Kerbe hauen. Wo liegt hier genau das Problem für SEO?

Schlechte Nachbarschaft durch Content Scraping und Links von gefährlichen Webseiten

In einem von mir analysierten aktuellen Fall wurden Inhalte einer Unternehmenswebseite gescrapte und auf einer fremden Domain (irgendwo auf einem Server in Zentralafrika) veröffentlicht. Um keinen eigenen Content aufbauen zu müssen, bedienen sich die Spammer gerne der Inhalte anderer, gut rankender Webseiten. Ärgerlich, denn die Seitenbetreiber haben viel Fleiß und Mühe in die Content-Erstellung gelegt. Gescrapte Inhalte führen jedoch zu Duplicate Content (DC). Und dieser schwächt die eigene Webseite, Rankingverluste sind somit wahrscheinlich!

Zusätzlich wurden die im Content enthaltenen Links vom Spammer beibehalten. Die Unternehmensseite in Deutschland wurde also von der Spam-Seite aus Zentralafrika verlinkt. Verlinkungen von oder zu gefährlichen Webseiten schädigen die Reputation der eigenen Website, denn ca. 60 % des Google Rankings werden weiterhin durch externe Links bestimmt.

Der Spammer hat außerdem Cloaking betrieben und dem GoogleBot andere Inhalte geliefert als dem Nutzer. Dem GoogleBot wurden die gescrapten Inhalte der Unternehmensseite gezeigt, dem Nutzer entweder Fotozubehör oder pornografische Inhalte präsentiert.

Aufgefallen ist dieses Vorgehen bei einer routinemäßigen Backlinkanalyse, die ABAKUS für diese Unternehmensseite durchgeführt hat.

Bleiben Sie aufmerksam!

Es ist notwendig, technisch auf dem aktuellen Stand zu bleiben, denn die Angriffe werden nicht weniger. Nehmen Sie es nicht persönlich: Der Großteil der Hacker sucht lediglich „Wirtsseiten“, um z.B. über Google Geld zu verdienen oder an sensible Daten zu gelangen. Beachten Sie die Aktualisierungshinweise in Ihrem CMS!

Fazit

Was können Sie selber tun, um die Basis für die Cyber-Sicherheit Ihrer Webseite zu verbessern?

- Nutzen Sie die Webmaster-Tools von Google oder Bing, dort finden Sie ggf. Informationen zu sicherheitsrelevanten Punkten.

- Analysieren Sie die Logfiles Ihres Servers. Unregelmäßigkeiten (oft einfach Peaks) sollten genauer betrachtet werden.

- Halten Sie Ihre eingesetzte Software (CMS, Plug-Ins, Themes usw.) aktuell!

- Führen Sie regelmäßig eine Backlinkanalyse durch.

- Prüfen Sie regelmäßig stichprobenartig auf Duplikate Ihrer Inhalte.

Lassen Sie einen erfahrenen SEO Ihre Webseite einmalig prüfen. Unsere Analyse ist die Bestandsaufnahme und Vorsorge Ihrer Website. Wir sind Mitglied des Hannover IT e.V. und beraten uns regelmäßig mit den Fachleuten des Netzwerkes über aktuelle Trends.

In der Regel lassen sich die Rankingverschlechterungen durch einen Hackerangriff wieder beheben, wenn schnell gehandelt wird.

Frage an unsere Leser: Ist Ihre Webseite oder Ihr Shop schon einmal attackiert worden?

Neueste Forenbeiträge zum Thema SEO Consulting

Von: nerd

am: 09.08.2023 - 11:28

in: Ich hab' da mal 'ne Frage

Alle Unterseiten verweisen per Canonical Link oder per Redirect auf die Startseite! (6)

Von: Felicitas

am: 13.06.2022 - 16:03

in: Ich hab' da mal 'ne Frage

Alle Unterseiten verweisen per Canonical Link oder per Redirect auf die Startseite! (6)

Von: arnego2

am: 17.06.2022 - 23:43

in: Ich hab' da mal 'ne Frage

Unbekannter URL-Parameter in WordPress (16)

Von: Jogger45

am: 23.03.2022 - 16:03

in: Content Management Systeme, Blog- & Shopsysteme

Verwandte Beiträge:

- Alternative Suchmaschinen 1: Swisscows, MetaGer, Qwant …

- Bad Neighbourhood ermitteln und verhindern

- Bildoptimierung für schnelle Ladezeiten Ihrer Webseite

- Bing Rankingfaktoren im Vergleich zu Google

- Das doppelte Lottchen oder Duplikate unerwünscht

- Google-Indexierung: Die Grundlage für gute Rankings

- Googles Core Web Vitals als Kennzahl für die Page Experience

- Größere Bedeutung von No Click Searches – Lösungsvorschläge für Ihre Website

- Höhere Klickraten durch Sonderzeichen in den SERPs

- Hidden Content und Infinite Scrolling: SEO Tipps zur Umsetzung

- In 3 Schritten zur perfekten Keyword Recherche

- Keyword Kannibalismus erkennen und beseitigen

- Keyword Monitoring Tool

- Keyword Tools

- Keywords im Singular oder Plural optimieren?

- Local SEO & Google My Business (GMB) Eintrag optimieren

- Marke und SEO: Wie messe ich die Bekanntheit?

- Mit Low Hanging Fruits schnelle Rankingverbesserungen erreichen

- Passage Based Indexing – Textpassagen als neuer Rankingfaktor

- SEO und CRO kombinieren

- SEO und Cyber Security

- SEO-Begriffe für Anfänger erklärt

- SEO-konforme 404-Seiten (Tipps und Beispiele)

- SERP Features erklärt

- Sind Eintragungen in Webkataloge sinnvoll

- So indexiert Google JavaScript Content

- Strukturen, die Google liebt – SEO mit strukturierten Daten

- Suchmaschinen im Ausland: Yandex, Baidu, Seznam und Naver

- Suchmaschinenoptimierung für Noxum

- SEO-Grundlagen: Webseitendesign

- Suchmaschinenoptimierung (SEO)

- SEO-Grundlagen: HTML Coding

- SEO-Grundlagen: Controlling

- SEO-Grundlagen: Suchmaschinenanmeldung

- SEO-Grundlagen: Zusammenfassung

- 10 SEO Browser Erweiterungen für Chrome und Firefox

- 10 SEO Tipps für Onlineshops

- 13 SEO Fehler – 13 neue Chancen

- Adobe Experience Manager (AEM) und Suchmaschinenoptimierung (SEO)

- Arten von Suchanfragen – Wie suchen die User?

- Bad Neighbourhood ermitteln und verhindern

- Bing Rankingfaktoren im Vergleich zu Google

- Crawl Budget Optimierung

- Das offene IndexNow Protokoll beschleunigt die Indexierung

- Die Mobile First Deadline ist hier – Ist Ihre Website vorbereitet?

- Durch Snippet Optimierung bessere Klickraten erzielen

- Dwell Time anschaulich erklärt

- E-E-A-T Faktoren durch Onpage und Offpage-Maßnahmen verbessern

- Forum & SEO

- Google-Indexierung: Die Grundlage für gute Rankings

- Höhere Klickraten durch Sonderzeichen in den SERPs

- Häufige SEO-Fehler

- htaccess – Ein mächtiges SEO-Werkzeug

- HTTP Status Codes – SEO Relevanz & Tipps

- JavaScript & SEO

- Mit Low Hanging Fruits schnelle Rankingverbesserungen erreichen

- Neos CMS: SEO-Einstellungen erklärt

- Page Experience Update von Google: Core Web Vitals und die Lösung

- Rankingvorteile durch Löschen oder Erneuern alter Inhalte?

- robots.txt

- SEO Grundlagen:Externe Verlinkungen – Webseitenstruktur

- SEO und CRO kombinieren

- SEO-Begriffe für Anfänger erklärt

- SEO-Mythen

- SERP Features erklärt

- So indexiert Google JavaScript Content

- Suchmaschineneintrag

- Umstellung auf HTTP/2 – Ladezeit Check