Das offene IndexNow Protokoll beschleunigt die Indexierung

Beim Website indexieren nehmen Suchmaschinen Webseiten in ihren Index auf. Diese Aufnahme ist die Voraussetzung dafür, dass die Website später in den Suchergebnissen erscheint. (Besonders bei Javascript Content kann dieser Prozess etwas aufwendiger sein. Die Javascript-Indexierung muss daher gesondert betrachtet werden.)

Suchmaschinen haben 2 Methoden Websitecontent zu indexieren:

- Pull

- Push

Bei der Pull-Methode besucht der Suchmaschinen-Crawler die Website und stellt dann eventuelle Änderungen fest. Dafür muss die Seite gecrawlt und die Sitemap eingelesen werden. Wie oft die Seite gecrawlt wird, hängt von mehreren Faktoren (z.B. der Verlinkung) ab. Unter Umständen vergehen so mehrere Tage bis eine neue Seite im Index erscheint.

Bei der Push-Methode erhält die Suchmaschine eine Nachricht über Veröffentlichungen oder Änderungen und besucht dann die betreffenden URLs der Website. Websitebetreiber beschleunigen so den Indexierungsprozess, die Wartezeit auf den nächsten Crawler-Besuch entfällt.

Das von Microsoft (Bing) und Yandex entwickelte quelloffene IndexNow Protokoll zur schnelleren Website Indexierung basiert auf dieser Push-Methode. Die beiden teilnehmenden Suchmaschinen erhalten bei korrekter Einbindung eine Nachricht über die veränderten oder neu hinzugekommenen Seiten. Alle anderen Suchmaschinen sind zur Teilnahme eingeladen.

Im Moment gibt es bei der Google Indexierung noch keine Unterstützung des IndexNow Protokolls. Google prüft aber, ob eine Implementierung erfolgt.

Suchmaschinen müssen mit IndexNow Websites nicht mehr selbständig auf Veränderungen prüfen. Sie erhalten eine direkte Nachricht. Somit erspart diese Methode den Suchmaschinen Arbeit und verbessert die User-Zufriedenheit durch schnelles Website indexieren. Das häufige, oft ergebnislose, Crawlen von Websites reduziert sich bei dieser Methode erheblich. Die durch die Bots enstehende Serverlast sinkt.

Wie übermittle ich mit IndexNow neue oder veränderte Seiten?

Durch eine API teilen Sie Yandex und Bing mit, dass sich neue Inhalte auf Ihrer Website befinden.

Dazu generieren Sie im ersten Schritt auf bing.com den API-Key.

Diesen Key (beispielsweise: 32131235434344abcdefwea1420fc7895fcba) speichern Sie in einer .txt-Datei und laden diese in das Root-Verzeichnis Ihrer Website.

Anschließend senden Sie die URL mit dem Key

https://www.bing.com/indexnow?url&key=32131235434344abcdefwea1420fc7895fcba

an Bing. Andere Suchmaschinen wie Yandex müssen einzeln benachrichtigt werden. Es ist auch möglich mehrere URLs gleichzeitig zu übermitteln und Parameter zu verändern. Für mehr Infos lesen Sie bitte die offizielle Dokumentation.

Die Seite wird nun gecrawlt und wenn sie den Qualitätskriterien genügt, in den Index aufgenommen.

Für WordPress gibt es mittlerweile ein IndexNow Plugin, das die Einbindung erleichtert. Andere Content-Management-Systeme ziehen vermutlich bald nach. Auch das CDN (Content Delivery Network) Cloudfare unterstützt IndexNow.

Fazit zu IndexNow

Google hat seinen Crawling-Mechanismus immer mehr verfeinert. Der Googlebot unterstützt mittlerweile HTTP/2 in mehr als der Hälfte aller Crawls. Sodass auch ohne IndexNow in den letzten Jahren Crawlingressourcen gespart wurden. Crawl Budget Optimierung ist schon seit einiger Zeit in aller Munde. Trotzdem überlegt Google, IndexNow zu unterstützen. Das zeigt, dass in Sachen Crawling bzw. Indexierung noch Optimierungsbedarf besteht. IndexNow ist eine effektive Alternative für User, die ihre Website indexieren lassen wollen, ohne lange auf die Aufnahme in den Index warten zu müssen.

Google Indexierung in der Google Search Console

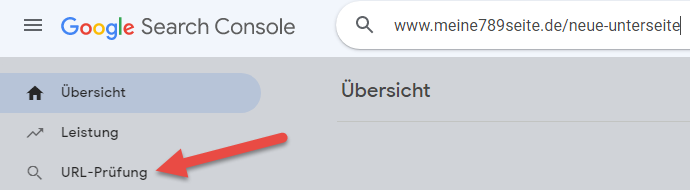

Für eine schnelle Google Indexierung gibt es noch eine Alternative zum IndexNow Protokoll. Gehen Sie in der Google Search Console auf URL Prüfung und reichen Sie Ihre veränderte oder neue URL ein. Nach erfolgreicher Qualitätsprüfung erfolgt dann die Indexierung.

Exkurs: Was ist Crawling? Wie sperre ich Crawler?

Crawler besuchen in regelmäßigen Abständen vorhandene Websites und verfolgen die internen bzw. externen Links. So gelangen sie zu neuen Seiten. Diese Robots oder Spider funktionieren automatisch. Den ausgelesenen Content speichern sie im Cache und indexieren ihn. Der Suchmaschinen-Algorithmus legt dabei das Ranking der im Index vorhandenen Seiten auf den Suchergebnisseiten (SERPs) fest.

Die Bots der Suchmaschinen unterscheiden sich in ihren IPs. Google hat vor einiger Zeit eine Liste mit den IPs der Googlebots veröffentlicht. Hieran können Sie erkennen, ob Ihre Seite von einem Googlebot oder Spambot besucht wurde. Sie können jetzt die Spider/Robots sperren, die nur vorgeben Googlebots zu sein. So senken Sie die Serverlast und verbessern die Performance Ihrer Website. Diese Spambots erzeugen keinen Index. Sie filtern Ihre Seite beispielsweise nach Emailadressen.

Zum Aussperren der unerwünschten Spider bietet sich die robots.txt an. Hier notieren Sie

User-agent: Spambot Disallow: /

Diese Methode funktioniert allerdings nur, wenn die Bad Bots sich an die Richtlinie in der robots.txt halten. Sperren Sie deshalb unliebsame Besucher mit Ihrer .htaccess aus:

order allow, deny deny from 9.8.7.6 deny from 5.4.3.2 allow from all

Nach deny from ergänzen Sie die nicht erwünschten IPs, schon haben die unerwünschten Spambots keinen Zugriff mehr auf Ihre Seite.

Sollte dies alles nicht ausreichen, gibt es noch die Möglichkeit, IP-Adressen mit dem Netzwerktool iptables zu sperren.

Behalten Sie wichtigsten Kennzahlen Ihrer Website im Blick, überprüfen bzw. beschleunigen Sie die Indexierung Ihrer Inhalte und sperren Sie Spambots konsequent aus.

Neueste Forenbeiträge zum Thema SEO Consulting

Von: nerd

am: 09.08.2023 - 11:28

in: Ich hab' da mal 'ne Frage

Alle Unterseiten verweisen per Canonical Link oder per Redirect auf die Startseite! (6)

Von: Felicitas

am: 13.06.2022 - 16:03

in: Ich hab' da mal 'ne Frage

Alle Unterseiten verweisen per Canonical Link oder per Redirect auf die Startseite! (6)

Von: arnego2

am: 17.06.2022 - 23:43

in: Ich hab' da mal 'ne Frage

Unbekannter URL-Parameter in WordPress (16)

Von: Jogger45

am: 23.03.2022 - 16:03

in: Content Management Systeme, Blog- & Shopsysteme

Verwandte Beiträge:

- Alternative Suchmaschinen 1: Swisscows, MetaGer, Qwant …

- Bad Neighbourhood ermitteln und verhindern

- Bildoptimierung für schnelle Ladezeiten Ihrer Webseite

- Bing Rankingfaktoren im Vergleich zu Google

- Das doppelte Lottchen oder Duplikate unerwünscht

- Google-Indexierung: Die Grundlage für gute Rankings

- Googles Core Web Vitals als Kennzahl für die Page Experience

- Größere Bedeutung von No Click Searches – Lösungsvorschläge für Ihre Website

- Höhere Klickraten durch Sonderzeichen in den SERPs

- Hidden Content und Infinite Scrolling: SEO Tipps zur Umsetzung

- In 3 Schritten zur perfekten Keyword Recherche

- Keyword Kannibalismus erkennen und beseitigen

- Keyword Monitoring Tool

- Keyword Tools

- Keywords im Singular oder Plural optimieren?

- Local SEO & Google My Business (GMB) Eintrag optimieren

- Marke und SEO: Wie messe ich die Bekanntheit?

- Mit Low Hanging Fruits schnelle Rankingverbesserungen erreichen

- Passage Based Indexing – Textpassagen als neuer Rankingfaktor

- SEO und CRO kombinieren

- SEO und Cyber Security

- SEO-Begriffe für Anfänger erklärt

- SEO-konforme 404-Seiten (Tipps und Beispiele)

- SERP Features erklärt

- Sind Eintragungen in Webkataloge sinnvoll

- So indexiert Google JavaScript Content

- Strukturen, die Google liebt – SEO mit strukturierten Daten

- Suchmaschinen im Ausland: Yandex, Baidu, Seznam und Naver

- Suchmaschinenoptimierung für Noxum

- SEO-Grundlagen: Webseitendesign

- Suchmaschinenoptimierung (SEO)

- SEO-Grundlagen: HTML Coding

- SEO-Grundlagen: Controlling

- SEO-Grundlagen: Suchmaschinenanmeldung

- SEO-Grundlagen: Zusammenfassung

- 10 SEO Browser Erweiterungen für Chrome und Firefox

- 10 SEO Tipps für Onlineshops

- 13 SEO Fehler – 13 neue Chancen

- Adobe Experience Manager (AEM) und Suchmaschinenoptimierung (SEO)

- Arten von Suchanfragen – Wie suchen die User?

- Bad Neighbourhood ermitteln und verhindern

- Bing Rankingfaktoren im Vergleich zu Google

- Crawl Budget Optimierung

- Das offene IndexNow Protokoll beschleunigt die Indexierung

- Die Mobile First Deadline ist hier – Ist Ihre Website vorbereitet?

- Durch Snippet Optimierung bessere Klickraten erzielen

- Dwell Time anschaulich erklärt

- E-E-A-T Faktoren durch Onpage und Offpage-Maßnahmen verbessern

- Forum & SEO

- Google-Indexierung: Die Grundlage für gute Rankings

- Höhere Klickraten durch Sonderzeichen in den SERPs

- Häufige SEO-Fehler

- htaccess – Ein mächtiges SEO-Werkzeug

- HTTP Status Codes – SEO Relevanz & Tipps

- JavaScript & SEO

- Mit Low Hanging Fruits schnelle Rankingverbesserungen erreichen

- Neos CMS: SEO-Einstellungen erklärt

- Page Experience Update von Google: Core Web Vitals und die Lösung

- Rankingvorteile durch Löschen oder Erneuern alter Inhalte?

- robots.txt

- SEO Grundlagen:Externe Verlinkungen – Webseitenstruktur

- SEO und CRO kombinieren

- SEO-Begriffe für Anfänger erklärt

- SEO-Mythen

- SERP Features erklärt

- So indexiert Google JavaScript Content

- Suchmaschineneintrag

- Umstellung auf HTTP/2 – Ladezeit Check