Das doppelte Lottchen oder Duplikate unerwünscht

Vom richtigen Umgang mit Duplicate Content im Onlineshop oder auf der Website

Was in dem weltbekannten Roman von Erich Kästner sehr originell daher kommt – zwei Mädchen, die sich bis auf das Haar gleichen – kann für einen Webseitenbetreiber zum Problem werden: zwei Inhalte, die sich bis auf das Wort gleichen. Diese Duplikate, auch als Duplicate Content (DC) bezeichnet, werden von Suchmaschinen nicht gerne gesehen und meist mit einer Entfernung oder Nichtaufnahme in den Index sanktioniert. Das Vorgehen aus Sicht einer Suchmaschine ist logisch: kein Suchender möchte zu seiner Suchanfrage identische Inhalte ausgeliefert bekommen, egal, ob diese von ein und derselben Domain oder von unterschiedlichen Webseiten kommen. KI-Tools haben dieses Problem noch zusätzlich verstärkt. Schließlich besteht bei KI-generierten Texten häufig die Gefahr, dass diese zu ähnlich sind.

Doch so sehr das Problem identischer Inhalte auch bekannt ist, kommt es in der Praxis sehr häufig vor und selbst erfahrene Webmaster suchen nach Lösungen im Google konformen Umgang mit DC.

Was sind die häufigsten Ursachen von Duplikaten?

Ursache 1 – Verwendung von Händlerbeschreibungen (externe Duplikate)

Hiervon sind besonders Onlineshops betroffen, die für die angebotene Produktpalette der Einfachheit halber die mitgegebenen Händlerbeschreibungen bzw. Herstellertexte verwenden. Das ist zwar die Variante des geringsten Aufwandes, wird daher aber auch von vielen Onlineshop-Betreibern verwendet und erzeugt in Masse Duplikate. Davon abgesehen verwenden natürlich auch die Hersteller meist selber diese Texte auf der eigenen Seite und haben als Urheber der Inhalte bei Suchmaschinen die Nase im Ranking oft vorn.

Ursache 2 – Ein Inhalt in unterschiedlichen Kategorien (interne Duplikate)

Ein klassisches Beispiel für diese Art der Duplikatbildung ist das Angebot eines Produktes in unterschiedlichen Kategorien, z. B. einmal in „Neuheiten“ und dann nochmal in der thematisch passenden Kategorie. Auf diese Weise wird ein und dasselbe Produkt an unterschiedlichen Stellen und mit unterschiedlichen URLs im Shop abgelegt. Ebenfalls sehr oft werden Unterkategorien in zwei oder mehreren passenden übergeordneten Kategorien eingeordnet und so mit unterschiedlichen URLs, aber gleichen Inhalten versehen, im Shop verankert. So könnte z. B. in einem Geschenke-Shop eine Unterkategorie „Individuelle Geschenke für Frauen“ gleichzeitig in der Hauptkategorie „Für SIE“ und in der Kategorie „Muttertag“ abgelegt werden.

Ursache 3 – Verwendung von Standard-Texten (interne Duplikate)

Oft reduzieren Webmaster den Aufwand für SEO-Texte, indem Standard-Texte verfasst werden, die dann auf allen passenden Unterseiten ausgegeben werden, wenn sich der Inhalt dahinter nur minimal unterscheidet (z. B. weil sich nur die Farbe oder Größe eines Produktes geändert hat).

Ursache 4 – Duplikate durch Parameter-URLs (interne Duplikate)

Viele Shop-Systeme oder Content Management Systeme (CMS) generieren automatisch Parameter-URLs mit anhängenden Session- oder Filter-IDs. Allein die Sortierung einer Produktliste nach bestimmten Kriterien kann ein Duplikat erzeugen, wenn die entsprechenden Parameter nicht von der Indexierung gesperrt werden. Auch der Aufruf einer Website mit und ohne vorangestelltes „www“ erzeugt ein klassisches Duplikat.

Ursache 5 – Datenklau (externe Duplikate)

Das Internet ist kein rechtsfreier Raum. Dennoch geschieht es häufiger, als man denkt, dass die eigenen, sorgfältig recherchierten und erstellten Texte von Dritten kopiert und auf anderen Seiten ausgegeben werden. Auch wenn dies rein rechtlich eine unbestrittene Urheberrechtsverletzung ist, kann der Google Crawler das nicht automatisch erkennen und unter Umständen den dreist entwendeten Inhalt besser werten. Manchmal kommt man diesen Betrügereien erst dann auf die Schliche, wenn die eigenen Inhalte nicht mehr zu finden sind oder deutlich an Positionen verloren haben.

Mehr Inhalte – mehr Sichtbarkeit?

Worin besteht nun das konkrete Problem, wenn Duplikate auftreten?

Sehr pragmatische Webmaster argumentieren gerne, dass es doch gut wäre, Google die Wahl zu überlassen und die beste URL auszusuchen. Außerdem böten mehr Inhalte doch immer ein Mehr an Sichtbarkeit und der Wettbewerb könnte stärker verdrängt werden.

Ganz so einfach ist es dann doch nicht. Die größte Gefahr bei der Duplikatbildung, egal ob intern oder extern, ist die Entfernung einer oder mehrerer Duplikate aus dem Google-Index. Damit wären auch alle vorhandenen Rankings verloren und die Seite kann keinen organischen Traffic (unbezahlte Klicks) erzeugen.

Hat z. B. ein Shop-Betreiber eine Weihnachtsgeschenke-Kategorie pünktlich zur Vorweihnachtszeit aufgebaut und diese Inhalte auch noch an anderer Stelle seines Onlineshops verankert, wäre es für ihn katastrophal, wenn Google genau die Weihnachts-Inhalte aus dem Index wirft, statt z. B. der anderen Geschenke-Kategorie. Bei Duplikaten kann der Webmaster also nicht steuern, wie die Suchmaschine damit umgeht. Dies stellt ein Unternehmensrisiko dar, dem man sich nicht aussetzen möchte. Ein anderer Fall wäre keine Deindexierung des doppelten Inhaltes, sondern eine Abwertung im Ranking. Je nach Saison und Nachfrage könnte dann gerade das „falsche“ Produkt an Rankings verlieren und kaum noch gefunden werden. Weiterhin ist eine klassische Folge von Duplikaten – sofern Google sie im Index belässt – dass sie sich gegenseitig im Ranking behindern, da sie sich selber Konkurrenz machen. Das führt meist dazu, dass beide URLs nicht so gut positioniert werden, wie es ohne Konkurrenz-Situation möglich wäre.

Bei externen Duplikaten, also identischen Inhalten auf unterschiedlichen Domains, bewertet Google nach folgenden Kriterien:

1. Auf welcher Domain wurde der Inhalt zuerst veröffentlicht?

Hier ist nicht der exakte Zeitpunkt des Live-Gangs der Seite entscheidend, sondern wann der Crawler die Seite das erste Mal gesehen und in den Index genommen hat. Suchmaschinen gehen davon aus, dass der erste Publisher sehr wahrscheinlich auch der Urheber ist.

2. Welches ist die stärkere Domain?

Haben zwei oder mehrere Seiten identische Inhalte fast gleichzeitig gelauncht (kommt z. B. häufig bei Pressemitteilungen vor), gibt die Suchmaschine beim Ranking fast immer der stärkeren Domain den Vorzug. Das ist die Website, die mehr Trust, Sichtbarkeit, Backlinks und Autorität bei der Suchmaschine besitzt.

Wie kann ich Duplikate finden?

Wer sich aktiv auf die Suche nach internen oder externen Duplikaten seiner Inhalte machen möchte, dem stellen wir hier einige Hilfsmittel vor.

1. Logik der Webseitenstruktur

Die meisten Webmaster kennen ihre Website oder den Onlineshop und wissen genau, ob sich Kategorien oder Produkte durch das Anzeigen in unterschiedlichen Bereichen doppeln. Hier stellt sich weniger die Frage, wie finde ich Duplikate, sondern wie gehe ich im CMS oder Shop-System damit um. Darauf gehen wir etwas später näher ein.

2. Google-Suche

Auch die Google-Suche kann beim Aufspüren von Duplikaten hilfreich sein, vorausgesetzt, die Duplikate befinden sich noch im Index. Kopieren Sie einen Abschnitt oder die Produktbeschreibung einer Seite und geben Sie diesen Textausschnitt in das Suchfeld bei Google ein. Verwenden Sie bei der Eingabe des Textausschnittes am Anfang und Ende Anführungszeichen, wie bei einem Zitat, um nur echte 1:1 Duplikate zu finden. Gibt Google mit Ausnahme der eigenen Seite, von der dieser Textausschnitt stammt, keine weiteren Ergebnisse an, existieren keine internen oder externen Duplikate im Index.

Gibt es weitere Suchergebnisse oder zeigt Google als ergänzende Meldung folgenden Hinweis an, deutet das auf Duplikate und der Webmaster sollte sich die Ergebnisse genauer anschauen. Bei dieser Meldung sollten Sie stutzig werden: „Damit du nur die relevantesten Ergebnisse erhältst, wurden einige Einträge ausgelassen, die den 2 angezeigten Treffern sehr ähnlich sind. Du kannst bei Bedarf die Suche unter Einbeziehung der übersprungenen Ergebnisse wiederholen.“

3. Finden durch Nicht-Finden

Klingt kompliziert, ist es aber nicht. Findet ein Webmaster eine bestimmte URL nicht im Index, kann das auf ein Problem mit Duplikaten deuten. Dann ist es möglich, dass Google diesen Inhalt nicht indexiert hat, weil eine andere Seite (intern oder extern) ihn schon veröffentlicht hat. Auch hier kann man wieder mit einem Textausschnitt der nicht indexierten Seite eine Suchanfrage starten und schauen, welche Ergebnisse ausgegeben werden. Bei internen Duplikaten beginnt die Arbeit des Webmasters, bei externen Duplikaten muss geprüft werden, ob diese widerrechtlich entstanden sind oder ob es sich um rechtmäßige Kopien handelt.

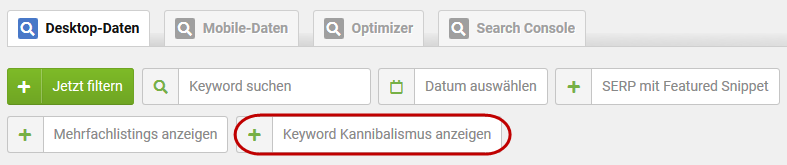

4. Keyword-Kannibalismus prüfen

Verschiedene SEO-Tools, wie z. B. Sistrix, prüfen die rankenden Keywords einer Domain nach Kannibalismus.

Quelle: de.sistrix.com

Gibt es mehr als eine URL, die für ein bestimmtes Keyword rankt? Hier kann, muss aber nicht, Duplicate Content dafür verantwortlich sein. In dem Fall sind die entsprechenden URLs zu überprüfen.

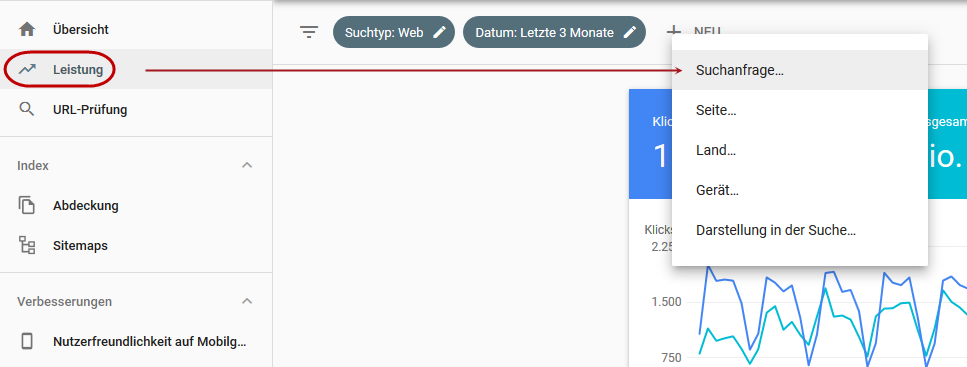

Gleiches kann man auch mit der Google Search Console untersuchen. Hier kann man im Leistungsbericht bei der Filterung nach Suchanfragen seine wichtigsten Keywords angeben und dann die dafür rankenden URLs ausgeben lassen:

A. Betrachtungszeitraum möglichst groß wählen. Maximal 16 Monate können im Rückblick ausgewählt werden. Dann wird die entsprechende Suchanfrage angegeben:

Quelle: https://search.google.com/search-console/performance/search-analytics

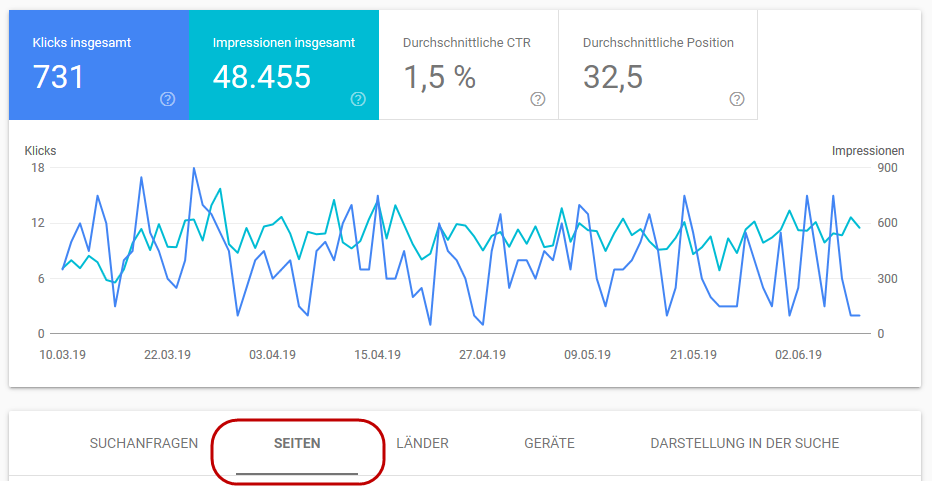

B. Anschließend wechselt man in der Ergebnisausgabe vom Tab SUCHANFRAGEN zu SEITEN.

Quelle: https://search.google.com/search-console/performance/search-analytics

Wird mehr als eine URL angezeigt, beginnt wieder die Arbeit des Prüfens, ob sich dort ggf. Duplikate befinden. Das funktioniert allerdings nur für interne Duplikate.

5. Duplicate-Content-Checker

Es gibt einige Tools im Netz, die dem Anwender ein Aufspüren von Duplikaten versprechen. Dazu gehören z. B. Copyscape, Articlechecker oder Similar Page Checker von Webconfs.

Eine Beschreibung und Testergebnisse zu diesen Tools sind u. a. auf chip.de zu finden: -> https://praxistipps.chip.de/duplicate-content-checker-3-tools-im-vergleich_37484

Prinzipiell können diese Tools sehr hilfreich sein, ersparen aber nicht das manuelle Abfragen der eigenen Inhalte.

6. Crawling-Tools

Mit Tools, wie z. B. dem Screaming Frog, kann die eigene Website so gecrawlt werden, wie das auch ein Suchmaschinen-Crawler vornimmt. Dabei können die gecrawlten Daten nach bestimmten Kriterien eingegrenzt und analysiert werden, was auf der Suche nach Duplikaten hilfreich ist. Beim Screaming Frog kann man sich z. B. alle Seiten anzeigen lassen, die identische Titles tragen. Das kann oft schon ein Indiz für ein echtes Duplikat sein, wenn z. B. Duplikate durch anhängende URL-Parameter gebildet werden.

Duplicate Content erkannt – und nun?

Ist man auf der Suche nach Duplikaten fündig geworden, stellt sich die Frage: Wie gehe ich damit um? Beim weiteren Vorgehen muss hier zwischen internen und externen Duplikaten unterschieden werden.

Interne Duplikate entfernen

Den pragmatischen Ansatz, am besten die Suchmaschine entscheiden zu lassen, welche URL sie nimmt, empfehlen wir nicht. Im Zweifelsfall entscheidet sie sich für die ungünstigere Variante und das Problem der sich gegenseitig behindernden Rankings wird damit auch nicht gelöst. Also heißt es doch: Ärmel hochkrempeln und aktiv werden.

Möglichkeit 1 – Das physische Entfernen

Existieren zwei oder mehrere URLs mit identischen Inhalten und gibt es für diese URLs keinen wirklichen Gebrauch, so können diese physisch entfernt, also vom Server gelöscht werden.

Die Duplikat-URLs geben dann einen 401- oder 410 Status-Code zurück.

Möglichkeit 2 – Parameter-Behandlung

Werden Duplikate durch angehängte Parameter an die URL gebildet, müssen diese bereinigt werden. Parameter hängt ein CMS- oder Shop-System oft automatisiert an eine URL, wenn ein Filter oder die Sortierfunktion genutzt oder eine interne Suchanfrage eingegeben wird.

Zu erkennen ist dies an Zusätzen an der URL, wie z. B. „?Id=“, ?sort=“ oder „search?“.

Diese Parameter werden idealerweise über die robots.txt von der Indexierung gesperrt.

Beispiel-Eintrag für das Sperren von Sortier-Parametern in der robots.txt:

Disallow: /*sSort=

Alternativ kann ein Canonical Tag verwendet werden, welches dazu dient, Suchmaschinen bei Duplikaten die Ranking relevante URL anzugeben. Dazu wird auf allen Seiten, die Duplikate bilden, im Quelltext im Head-Bereich das Tag zur entsprechenden Zielseite, die ranken soll, gesetzt:

<link rel=“canonical“ href=“https://www.domain-xy.de/rankende-zielseite.html/“ />

Möglichkeit 3 – 301-Weiterleitungen

Das Einrichten einer 301-Weiterleitung macht besonders dann Sinn, wenn der Inhalt einer bisherigen URL auf eine neue URL umzieht bzw. auch auf einer neuen URL sichtbar ist. Durch das Einrichten einer 301-Weiterleitung kann der bereits aufgebaute Trust und die Rankings der bisherigen URL, sofern vorhanden, auf die neue URL übertragen werden. Duplikate werden durch Weiterleitungen vermieden. Auch das klassische Duplikat beim Aufruf einer Domain mit und ohne „www“ wird idealerweise mit einer 301-Weiterleitungen gelöst. Dazu wird in der htaccess-Datei folgende Anweisung eingetragen:

RewriteEngine On

RewriteCond %{HTTP_HOST} !^www.domain.de$

RewriteRule ^(.*)$ http://www.domain.de/$1 [R=301,L]

Hier wird natürlich dann der eigene Domainname verwendet.

Möglichkeit 4 – Deindexierung

Sollen aus bestimmten Gründen zwei identische Inhalte behalten werden, kann ein Duplikat auch durch Deindexierung einer der beiden Seiten vermieden werden.

Dies kann z. B. der Fall sein, wenn man für Google Ads (ehemals AdWords) oder andere Kampagnen eine separate Landingpage erstellt, die in der Benutzerführung anders aufgebaut ist, inhaltlich aber der eigentlichen Seite im Shop oder CMS gleicht. Diese wird dann über die Meta-Angabe „robots“ auf „noindex“ gesetzt, sodass Suchmaschinen diese Seiten nicht indexieren dürfen:

<meta name=“robots“ content=“noindex, follow“>

Prinzipiell sollte die Seite auf “noindex“ gesetzt werden, welche weniger stark in ihrer Performance ist, also wenige/keine Rankings besitzt oder schlechter intern verlinkt wird.

Möglichkeit 5 – Unique URLs

Werden Duplikate dadurch gebildet, das Produkte in unterschiedlichen Kategorien zu finden sind und befindet sich die Pfadangabe dann auch in der URL, so ist hier folgender Ansatz für die Vermeidung von DC sinnvoll:

Aus der Produkt-URL werden alle Zwischenebenen entfernt, sodass, egal über welche Kategorie zu dem Produkt gelangt wird, immer nur eine einzige URL ausgegeben wird.

Beispiel:

Produkt A ist in der Kategorie „Sales“ und unter „Holztische“ zu finden. Duplikate sind durch die URLs www.mein-shop.de/sales/esstisch-a.html und www.mein-shop.de/holztische/esstisch-a.html entstanden. Wird, egal in welcher Kategorie, nur die URL www.mein-shop.de/esstisch-a.html verlinkt, so entstehen auf diese Art keine Duplikate.

Möglichkeit 6 – Individuelle Produktbeschreibungen

Schreiben Sie eigene, einzigartige Produkttexte und verwenden Sie nicht die Herstellerbeschreibungen. Auch wenn dieser Ansatz wesentlich aufwändiger ist, so lohnt sich die Mühe, wenn die Produktseiten dafür mit Rankings belohnt werden. Verfügt ein Onlineshop über sehr viele Produkte, so beginnen Sie mit den wichtigsten Artikeln, mit den „Verkaufsschlagern“ oder mit den Top-Margen-Produkten und arbeiten Sie sich dann sukzessive voran.

Externe Duplikate entfernen

Möglichkeit 1 – Deindexierung bei Urheberrechtsverletzung

Wurden Inhalte der eigenen Website rechtswidrig von Dritten übernommen, ist neben den rechtlichen Aspekten eine schnelle Entfernung dieser Inhalte aus dem Google-Index wichtig. Dazu hat die Suchmaschine ein eigenes Formular zum Melden solcher Verstöße bereitgestellt -> https://support.google.com/legal/troubleshooter/1114905?hl=de

Möglichkeit 2 – Seien Sie der Schnellste und Stärkste

Müssen aus bestimmten Gründen identische Inhalte auf der eigenen und auf anderen Websites geteilt werden, hilft meist nur eins: Seien Sie der Schnellste! Seien Sie der Stärkste!

Sorgen Sie dafür, dass Google ganz schnell an den Inhalt kommt. Reichen Sie die neue URL sofort über die Google Search Console ein. Ergänzen Sie die XML-Sitemap mit der URL und posten Sie diese auch auf Social Media Kanälen, wenn es stimmig ist.

Versuchen Sie den Inhalt etwas zu variieren durch eine zusätzliche Einleitung, eine abschließende Zusammenfassung, ein eigenes Fazit oder anderen Ergänzungen an den duplizierten Inhalt.

Nutzen Sie alle Potentiale des SEO-Kanals, um Trust und Stärke für Ihre Domain aufzubauen. Werden Sie eine Marke, ein Spezialist im eigenen Bereich und ein Profi in dem, was Sie tun.

Damit wächst die Chance, auch bei externen Duplikaten gut zu ranken und im Index zu bleiben.

Neueste Forenbeiträge zum Thema SEO Consulting

Von: nerd

am: 09.08.2023 - 11:28

in: Ich hab' da mal 'ne Frage

Alle Unterseiten verweisen per Canonical Link oder per Redirect auf die Startseite! (6)

Von: Felicitas

am: 13.06.2022 - 16:03

in: Ich hab' da mal 'ne Frage

Alle Unterseiten verweisen per Canonical Link oder per Redirect auf die Startseite! (6)

Von: arnego2

am: 17.06.2022 - 23:43

in: Ich hab' da mal 'ne Frage

Unbekannter URL-Parameter in WordPress (16)

Von: Jogger45

am: 23.03.2022 - 16:03

in: Content Management Systeme, Blog- & Shopsysteme

Verwandte Beiträge:

- Alternative Suchmaschinen 1: Swisscows, MetaGer, Qwant …

- Bad Neighbourhood ermitteln und verhindern

- Bildoptimierung für schnelle Ladezeiten Ihrer Webseite

- Bing Rankingfaktoren im Vergleich zu Google

- Das doppelte Lottchen oder Duplikate unerwünscht

- Google-Indexierung: Die Grundlage für gute Rankings

- Googles Core Web Vitals als Kennzahl für die Page Experience

- Größere Bedeutung von No Click Searches – Lösungsvorschläge für Ihre Website

- Höhere Klickraten durch Sonderzeichen in den SERPs

- Hidden Content und Infinite Scrolling: SEO Tipps zur Umsetzung

- In 3 Schritten zur perfekten Keyword Recherche

- Keyword Kannibalismus erkennen und beseitigen

- Keyword Monitoring Tool

- Keyword Tools

- Keywords im Singular oder Plural optimieren?

- Local SEO & Google My Business (GMB) Eintrag optimieren

- Marke und SEO: Wie messe ich die Bekanntheit?

- Mit Low Hanging Fruits schnelle Rankingverbesserungen erreichen

- Passage Based Indexing – Textpassagen als neuer Rankingfaktor

- SEO und CRO kombinieren

- SEO und Cyber Security

- SEO-Begriffe für Anfänger erklärt

- SEO-konforme 404-Seiten (Tipps und Beispiele)

- SERP Features erklärt

- Sind Eintragungen in Webkataloge sinnvoll

- So indexiert Google JavaScript Content

- Strukturen, die Google liebt – SEO mit strukturierten Daten

- Suchmaschinen im Ausland: Yandex, Baidu, Seznam und Naver

- Suchmaschinenoptimierung für Noxum

- SEO-Grundlagen: Webseitendesign

- Suchmaschinenoptimierung (SEO)

- SEO-Grundlagen: HTML Coding

- SEO-Grundlagen: Controlling

- SEO-Grundlagen: Suchmaschinenanmeldung

- SEO-Grundlagen: Zusammenfassung

- 10 SEO Browser Erweiterungen für Chrome und Firefox

- 10 SEO Tipps für Onlineshops

- 13 SEO Fehler – 13 neue Chancen

- Adobe Experience Manager (AEM) und Suchmaschinenoptimierung (SEO)

- Arten von Suchanfragen – Wie suchen die User?

- Bad Neighbourhood ermitteln und verhindern

- Bing Rankingfaktoren im Vergleich zu Google

- Crawl Budget Optimierung

- Das offene IndexNow Protokoll beschleunigt die Indexierung

- Die Mobile First Deadline ist hier – Ist Ihre Website vorbereitet?

- Durch Snippet Optimierung bessere Klickraten erzielen

- Dwell Time anschaulich erklärt

- E-E-A-T Faktoren durch Onpage und Offpage-Maßnahmen verbessern

- Forum & SEO

- Google-Indexierung: Die Grundlage für gute Rankings

- Höhere Klickraten durch Sonderzeichen in den SERPs

- Häufige SEO-Fehler

- htaccess – Ein mächtiges SEO-Werkzeug

- HTTP Status Codes – SEO Relevanz & Tipps

- JavaScript & SEO

- Mit Low Hanging Fruits schnelle Rankingverbesserungen erreichen

- Neos CMS: SEO-Einstellungen erklärt

- Page Experience Update von Google: Core Web Vitals und die Lösung

- Rankingvorteile durch Löschen oder Erneuern alter Inhalte?

- robots.txt

- SEO Grundlagen:Externe Verlinkungen – Webseitenstruktur

- SEO und CRO kombinieren

- SEO-Begriffe für Anfänger erklärt

- SEO-Mythen

- SERP Features erklärt

- So indexiert Google JavaScript Content

- Suchmaschineneintrag

- Umstellung auf HTTP/2 – Ladezeit Check