Robots.TXT für Suchmaschinen richtig gemacht

Eine robots.txt Datei dient NICHT dazu, einem Spider der Suchmaschine und anderen Crawlern mitzuteilen, welche Seiten sie spidern dürfen, sondern primär dazu, welche Seiten (und Verzeichnisse) sie NICHT spidern dürfen.

Die robots.txt ist die erste Datei, die ein Crawler herunterlädt. Gerade für Google ist es wichtig, dass Ressourcen geschont werden. Jede gecrawlte Seite verursacht Kosten. Die Steuerung der Indexierung ist ein wichtiges Hilfsmittel. Man kann nett zu den Robots sein UND sein eigenes Crawling Budget schonen. Wenn Seiten vom Crawling ausgeschlossen werden, die sowieso nicht ranken sollen, kommen z.B. neue Seiten schneller in den Index und andere, wichtige Seiten werden häufiger vom GoogleBot besucht.

Was sind die Vorteile einer robots.txt?

Es folgen nun einige Gründe, die für das Benutzen einer robots.txt sprechen.

- Nicht alle Robots, die Ihre Seite besuchen, haben gute Absichten! Es gibt viele, viele Robots, deren einziger Zweck im Scannen Ihrer Webseite besteht und dem damit verbundenen Extrahieren Ihrer E-Mail Adresse zum Zwecke von Spam! Eine Liste der ’schlechten‘ Robots folgt später noch.

- Möglicherweise haben Sie Ihre Webseite noch nicht fertig erstellt oder sie beinhaltet bestimmte, zu schützende Teile. Ich habe zum Beispiel alle robots vor jeder Seite meiner Website ausgeschlossen, solange ich die Seiten noch designte. Ich wollte nicht, dass eine halb-fertige, nicht optimierte Seite mit einer unvollständigen Linkstruktur indexiert wird. Dies hätte dann ein schlechtes Licht auf mich und ABAKUS geworfen. Als die Website dann fertig war, erhielten die Robots auch Zugriff. Dieses Vorgehen gilt im Übrigen auch für die Zeit des Relaunches einer Website.

- Sie besitzen einen Mitgliedsbereich, der nicht im Google Cache auftauchen soll. Dem Robot den Zutritt zu verweigern stellt einen Weg dar, dies zu realisieren.

- Es gibt Dinge, die Sie privat halten möchten. Wenn Sie einen Blick auf die robots.txt Datei von ABAKUS werfen, werden Sie bemerken, dass ich das Indexieren der Profile aus dem Forum aus Gründen des Datenschutzes unterbinde. Einige Webmaster blockieren den robots auch den Zugriff auf ihr cgi-bin oder ihre Grafikverzeichnisse.

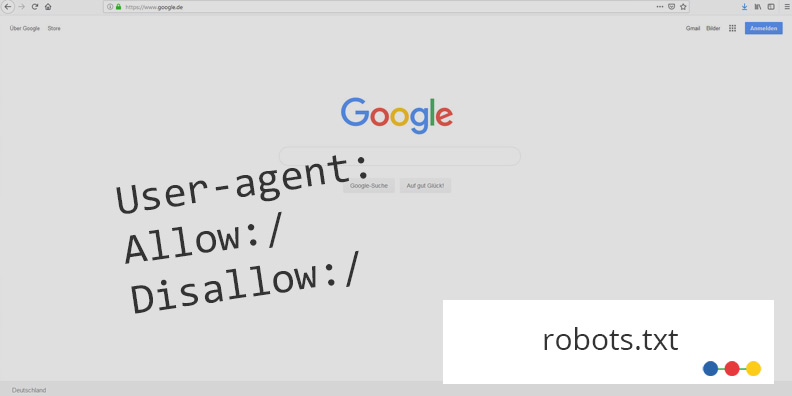

- Lassen Sie uns nun eine sehr einfache robots.txt Datei analysieren.

User-agent: EmailCollector Disallow: /

Diese Anweisung können Sie kopieren und in Notepad einfügen, als robots.txt speichern und dann in das root Verzeichnis Ihres Servers kopieren (dem Verzeichnis, in dem auch die Index-Datei liegt). Sie untersagen damit einem nervigen Programm namens EmailCollector den Zugriff auf Ihre Website. Das sind doch mal gute Nachrichten für Ihr E-Mail Postfach!

Leider habe ich hier nicht den nötigen Platz für ein komplettes Tutorial zur robots.txt. Jedoch kann ich Ihnen dieses hier empfehlen: SELFHTML – Robots kontrollieren

robots.txt: Beispiel

Der grundsätzliche Aufbau ist ganz simpel. Als erstes wird der Robot, der Crawler angesprochen. Wenn man alle anspricht kommt das Sternchen / der Asterisk „*“ zum Einsatz:

User-agent: *

Darauf folgt das Verzeichnis oder die Datei, die nicht gecrawlt werden soll, z.B.:

Disallow: /hiernicht/

Es wird immer der Pfad vom Stammverzeichnis angegeben, da die robots.txt auch dort liegt.

Versuchen Sie mal die robots.txt unserer Domain zu finden.

Als Beispiel für eine robots.txt für eine CMS siehe auch unseren Artikel: WordPress SEO

robots.txt: Generator

Der robots.txt Generator von IMN kann eine komplett neue robots.txt generieren, es kann aber auch eine bestehende robots.txt Datei eingelesen und hochgeladen werden. Es gibt eine Vorauswahl an Bots, die genutzt werden kann, die XML Sitemap kann auch gleich mit angegeben werden.

Hier geht es zum Robots.TXT Generator von Internet Marketing Ninjas.

Es gibt außerdem eine Vergleichsfunktion, um die bestehende und die neu generierte robots.txt Deiner Domain miteinander zu vergleichen.

Neueste Forenbeiträge zum Thema SEO Consulting

Von: nerd

am: 09.08.2023 - 11:28

in: Ich hab' da mal 'ne Frage

Alle Unterseiten verweisen per Canonical Link oder per Redirect auf die Startseite! (6)

Von: Felicitas

am: 13.06.2022 - 16:03

in: Ich hab' da mal 'ne Frage

Alle Unterseiten verweisen per Canonical Link oder per Redirect auf die Startseite! (6)

Von: arnego2

am: 17.06.2022 - 23:43

in: Ich hab' da mal 'ne Frage

Unbekannter URL-Parameter in WordPress (16)

Von: Jogger45

am: 23.03.2022 - 16:03

in: Content Management Systeme, Blog- & Shopsysteme

Verwandte Beiträge:

- Alternative Suchmaschinen 1: Swisscows, MetaGer, Qwant …

- Bad Neighbourhood ermitteln und verhindern

- Bildoptimierung für schnelle Ladezeiten Ihrer Webseite

- Bing Rankingfaktoren im Vergleich zu Google

- Das doppelte Lottchen oder Duplikate unerwünscht

- Google-Indexierung: Die Grundlage für gute Rankings

- Googles Core Web Vitals als Kennzahl für die Page Experience

- Größere Bedeutung von No Click Searches – Lösungsvorschläge für Ihre Website

- Höhere Klickraten durch Sonderzeichen in den SERPs

- Hidden Content und Infinite Scrolling: SEO Tipps zur Umsetzung

- In 3 Schritten zur perfekten Keyword Recherche

- Keyword Kannibalismus erkennen und beseitigen

- Keyword Monitoring Tool

- Keyword Tools

- Keywords im Singular oder Plural optimieren?

- Local SEO & Google My Business (GMB) Eintrag optimieren

- Marke und SEO: Wie messe ich die Bekanntheit?

- Mit Low Hanging Fruits schnelle Rankingverbesserungen erreichen

- Passage Based Indexing – Textpassagen als neuer Rankingfaktor

- SEO und CRO kombinieren

- SEO und Cyber Security

- SEO-Begriffe für Anfänger erklärt

- SEO-konforme 404-Seiten (Tipps und Beispiele)

- SERP Features erklärt

- Sind Eintragungen in Webkataloge sinnvoll

- So indexiert Google JavaScript Content

- Strukturen, die Google liebt – SEO mit strukturierten Daten

- Suchmaschinen im Ausland: Yandex, Baidu, Seznam und Naver

- Suchmaschinenoptimierung für Noxum

- SEO-Grundlagen: Webseitendesign

- Suchmaschinenoptimierung (SEO)

- SEO-Grundlagen: HTML Coding

- SEO-Grundlagen: Controlling

- SEO-Grundlagen: Suchmaschinenanmeldung

- SEO-Grundlagen: Zusammenfassung

- 10 SEO Browser Erweiterungen für Chrome und Firefox

- 10 SEO Tipps für Onlineshops

- 13 SEO Fehler – 13 neue Chancen

- Adobe Experience Manager (AEM) und Suchmaschinenoptimierung (SEO)

- Arten von Suchanfragen – Wie suchen die User?

- Bad Neighbourhood ermitteln und verhindern

- Bing Rankingfaktoren im Vergleich zu Google

- Crawl Budget Optimierung

- Das offene IndexNow Protokoll beschleunigt die Indexierung

- Die Mobile First Deadline ist hier – Ist Ihre Website vorbereitet?

- Durch Snippet Optimierung bessere Klickraten erzielen

- Dwell Time anschaulich erklärt

- E-E-A-T Faktoren durch Onpage und Offpage-Maßnahmen verbessern

- Forum & SEO

- Google-Indexierung: Die Grundlage für gute Rankings

- Höhere Klickraten durch Sonderzeichen in den SERPs

- Häufige SEO-Fehler

- htaccess – Ein mächtiges SEO-Werkzeug

- HTTP Status Codes – SEO Relevanz & Tipps

- JavaScript & SEO

- Mit Low Hanging Fruits schnelle Rankingverbesserungen erreichen

- Neos CMS: SEO-Einstellungen erklärt

- Page Experience Update von Google: Core Web Vitals und die Lösung

- Rankingvorteile durch Löschen oder Erneuern alter Inhalte?

- robots.txt

- SEO Grundlagen:Externe Verlinkungen – Webseitenstruktur

- SEO und CRO kombinieren

- SEO-Begriffe für Anfänger erklärt

- SEO-Mythen

- SERP Features erklärt

- So indexiert Google JavaScript Content

- Suchmaschineneintrag

- Umstellung auf HTTP/2 – Ladezeit Check